全功能AI大模型客户端AI as Workspace

简介

什么是 AI as Workspace ?

AI as Workspace(AIaW)是一个精心设计的AI客户端,全功能,轻量级;支持多工作区、插件系统、跨平台、本地优先+实时云同步、Artifacts。

主要特点

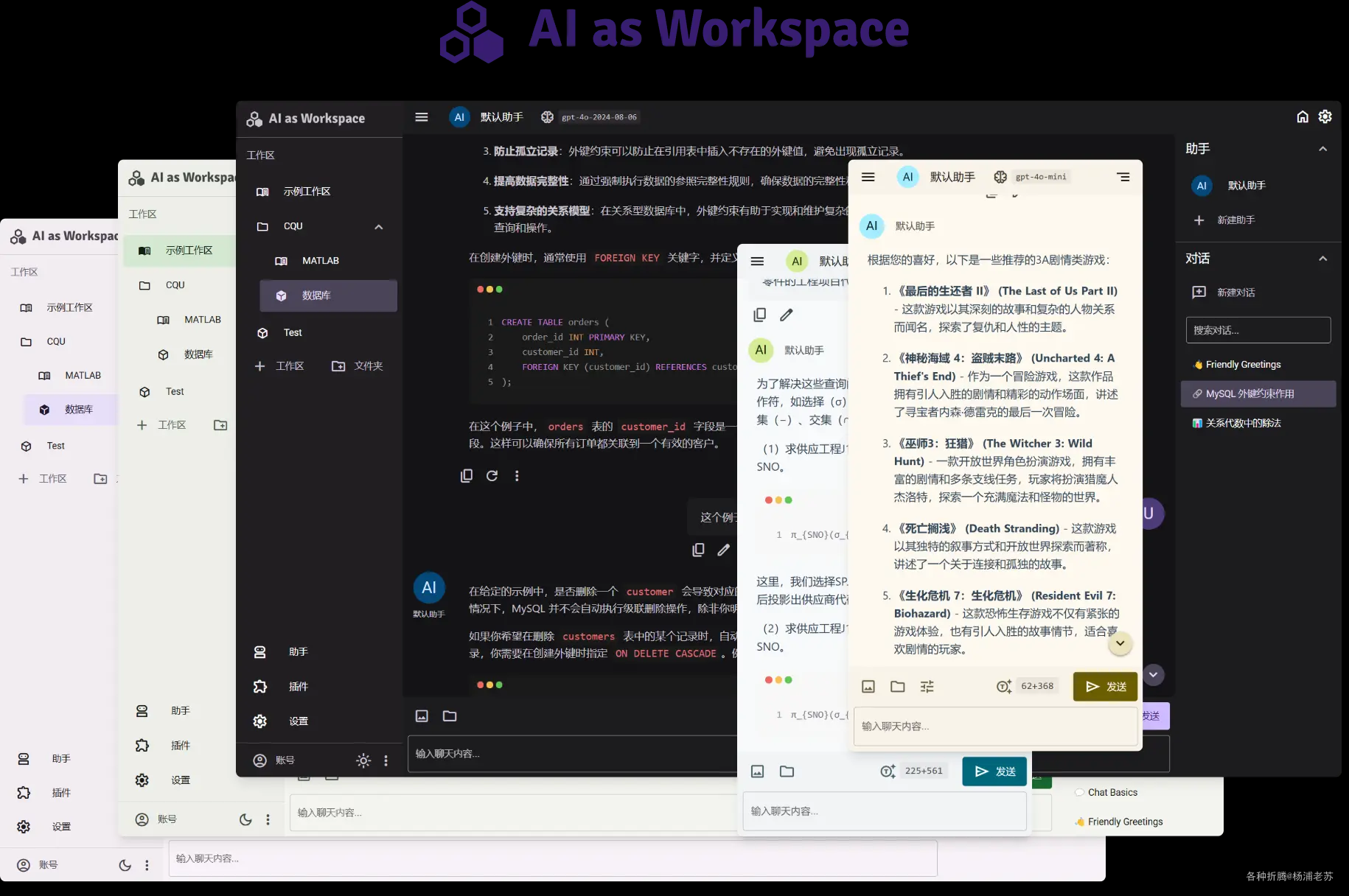

- 跨平台支持:响应式界面设计,适配各种设备(手机、电脑等)。

- 全功能和轻量级:提供全面的功能,同时保持高性能和快速启动。

- 多服务商支持:兼容

OpenAI、Anthropic、Google等多个AI服务。 - 多工作区支持:用户可以创建多个工作区,将不同主题的对话分隔开,支持嵌套文件夹管理。

- 插件系统:内置多个插件(如计算器、文档解析等),并且可以通过插件市场安装更多插件。

- 实时云同步:用户数据首先存储在本地,登录后可以实现跨设备的实时同步。

- 动态提示词:支持创建动态可复用的提示词,提升用户交互体验。

- Artifacts管理:用户可以将助手的回答转化为可编辑的

Artifacts,带有版本控制和代码高亮功能。

细节设计

- 用户输入预览:提供实时输入内容预览,提升用户体验。

- 代码粘贴优化:自动将从

VSCode复制的代码用代码块包裹并标明语言。 - 文本文件支持:支持直接添加文本文件,避免手动粘贴占用显示空间。

- 引用功能:通过拖选消息内容快速引用,方便针对性提问。

- 键盘控制:支持设置快捷键,便于快速滚动和操作。

AI as Workspace 是一个开源的、全功能的 AI 客户端,旨在提供高效的用户体验和灵活的使用场景,适用于需要高效管理和使用 AI 功能的用户。

准备

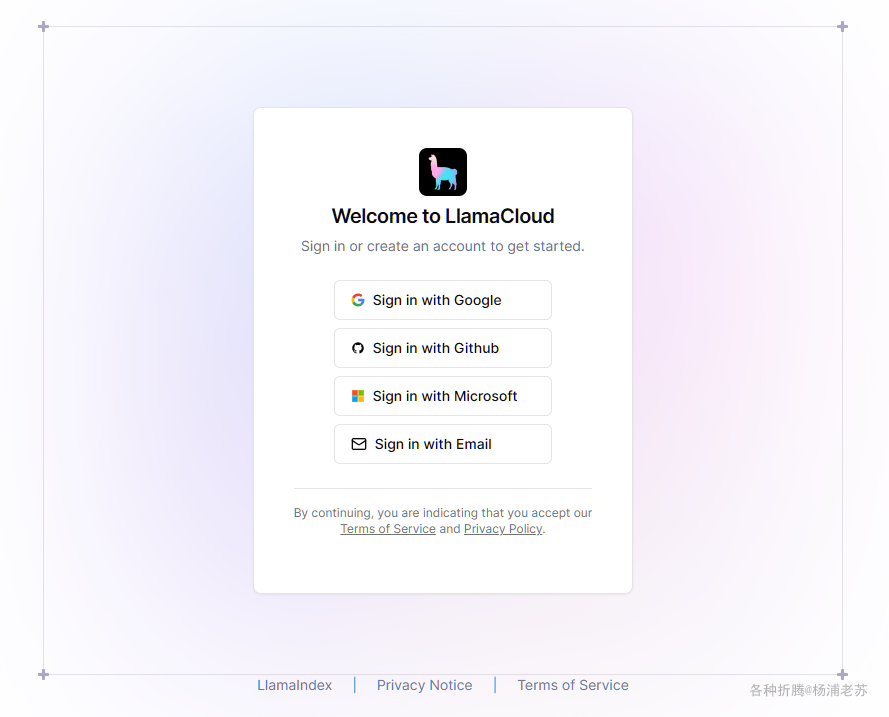

如果你希望使用内置的文档解析插件,则需要登录 LlamaCloud 并创建 API Key

这里有关于文档解析的详细说明:https://docs.aiaw.app/usage/file-parse.html,我们只要知道,目前是免费的就可以了

打开地址: https://cloud.llamaindex.ai,选择登录方式

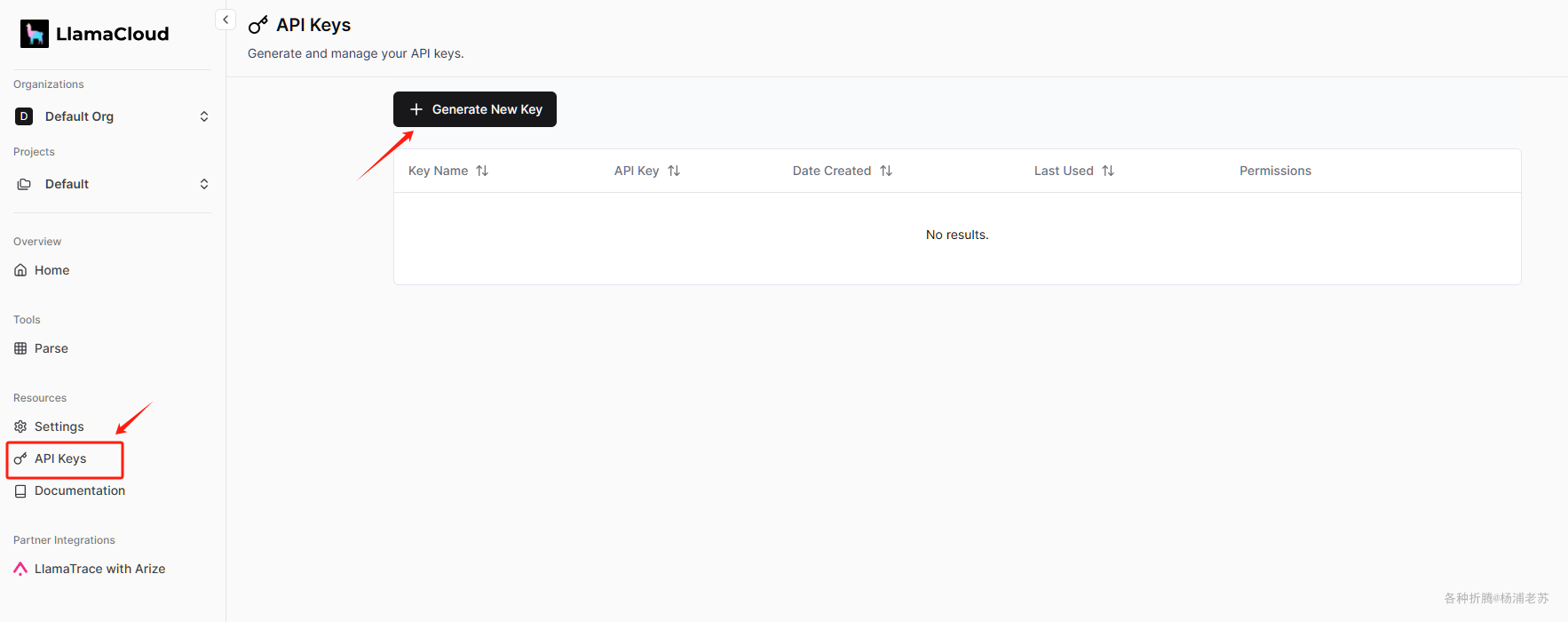

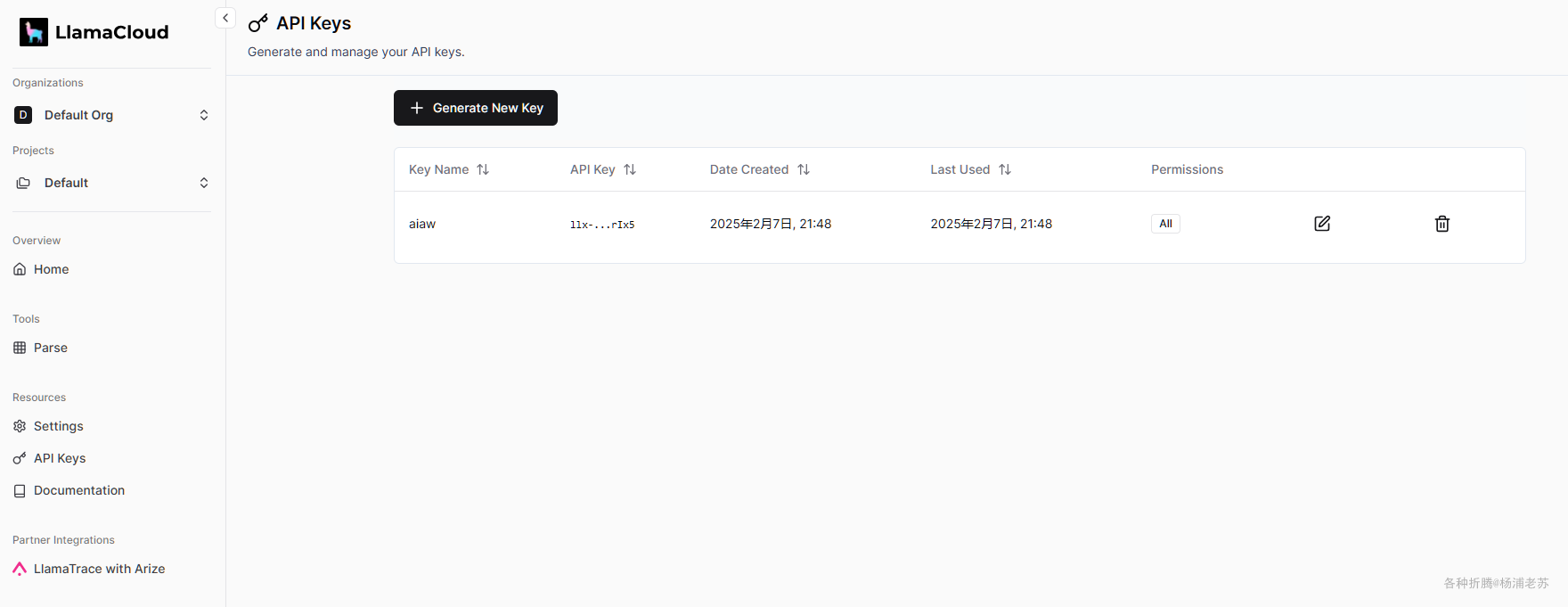

登录成功后,点击左侧菜单 API Keys

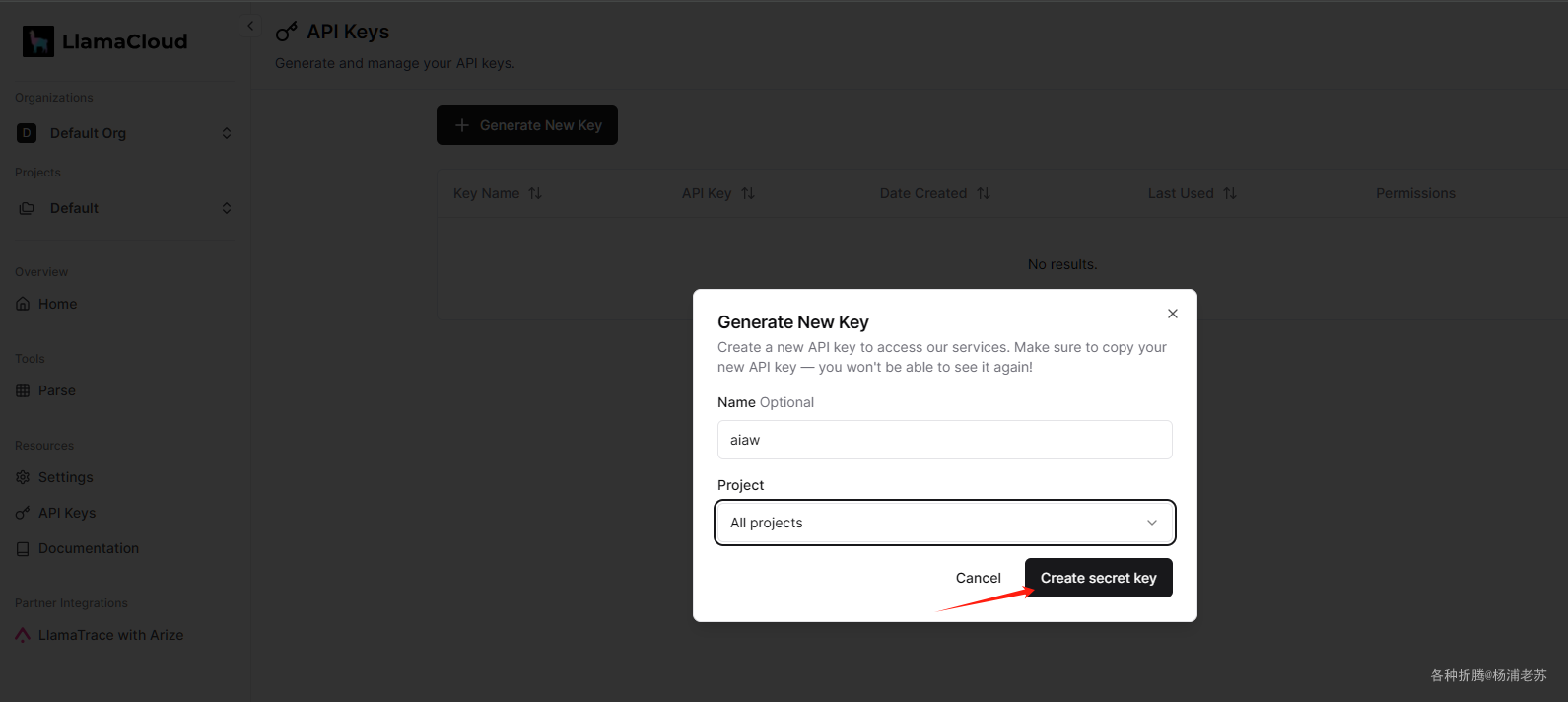

点 Generate New Key 创建一个 key

点 Create secret key 开始生成

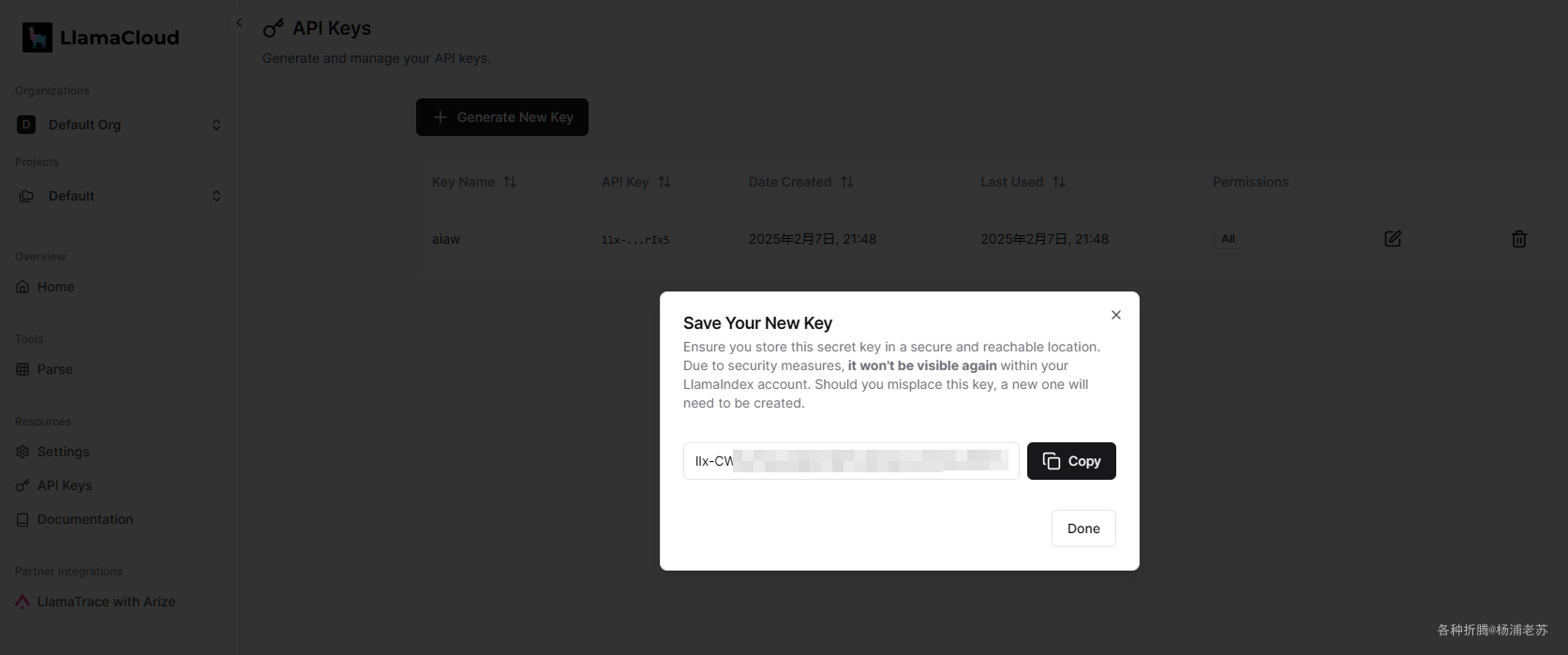

后续不会再显示,所以要妥善保管

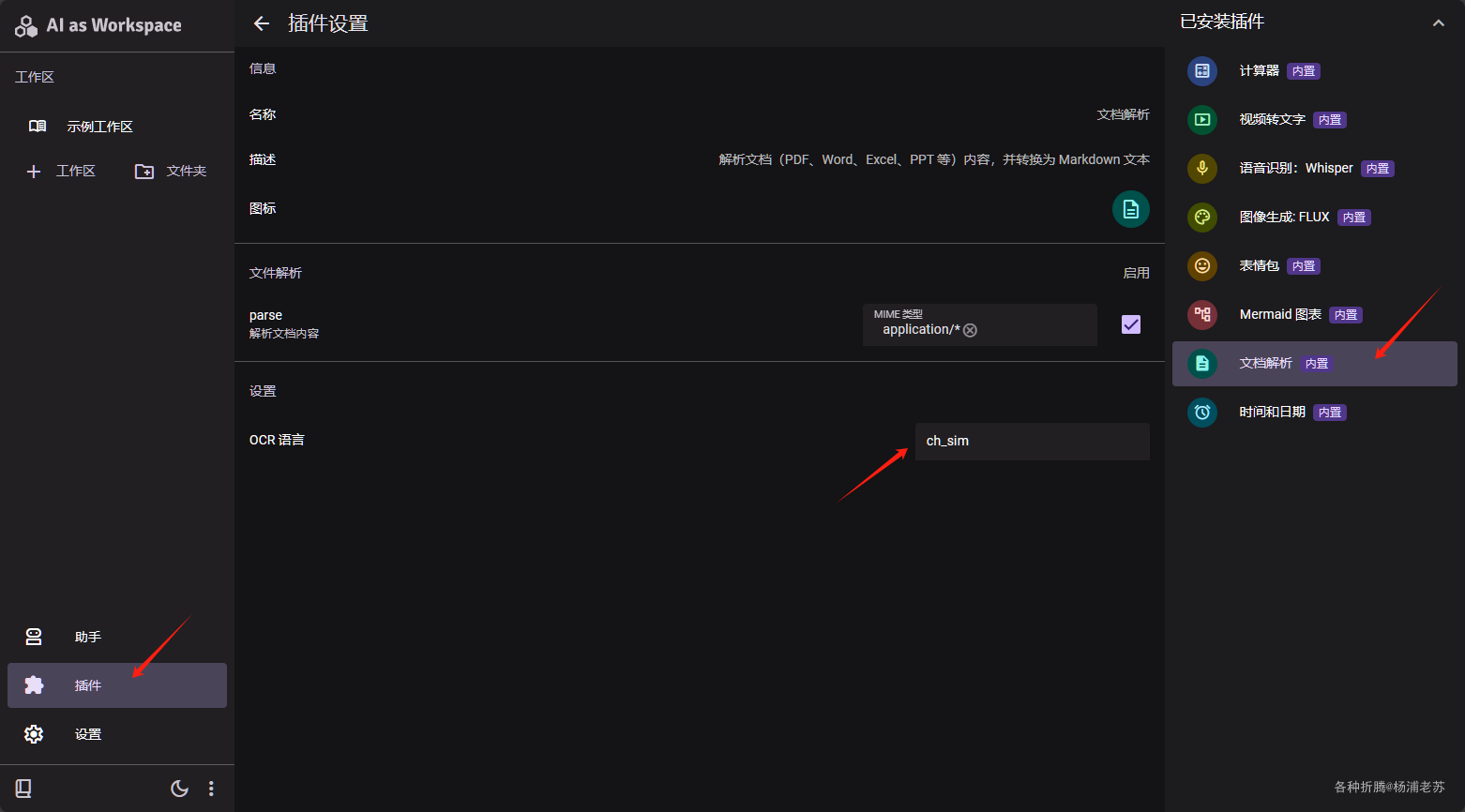

顺便说一下,如果中文文档多,可以试试将 OCR 语言设置为 ch_sim

安装

在群晖上以 Docker 方式安装。

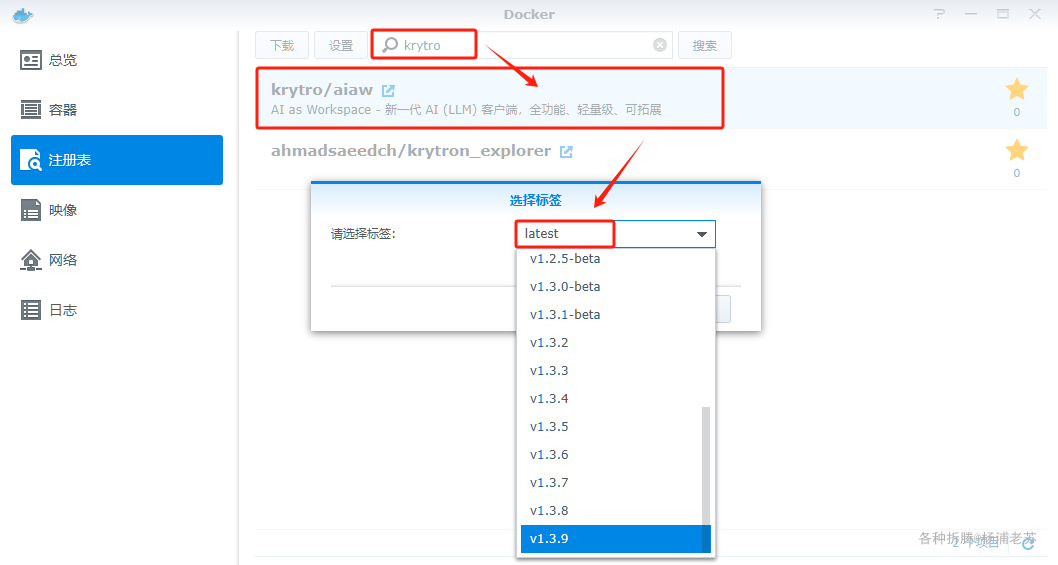

在注册表中搜索 krytro ,选择第一个 krytro/aiaw,版本选择 latest。

本文写作时,

latest版本对应为v1.3.9;

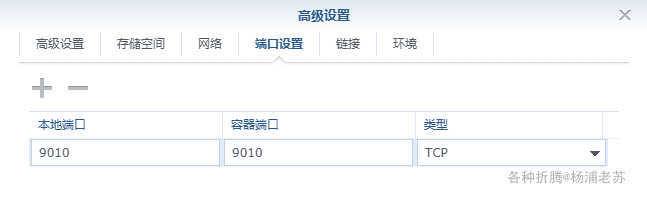

端口

本地端口不冲突就行,不确定的话可以用命令查一下

1 | # 查看端口占用 |

| 本地端口 | 容器端口 |

|---|---|

9010 |

9010 |

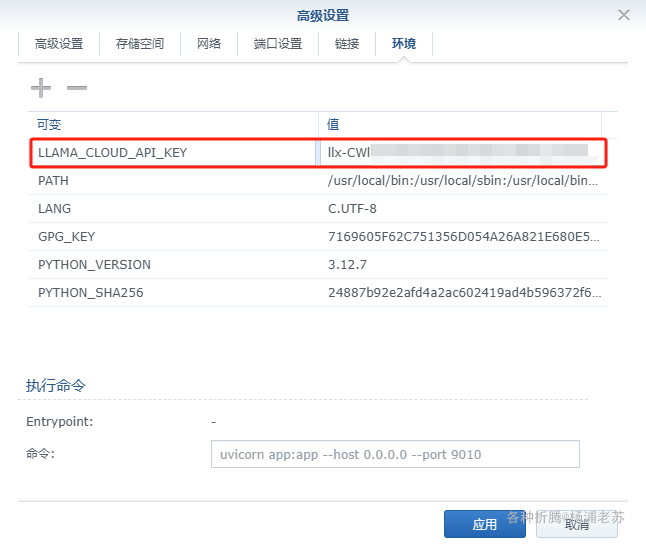

环境

| 可变 | 值 |

|---|---|

LLAMA_CLOUD_API_KEY |

LlamaCloud 网站上创建的 API Key |

需要说明的是,如果你不打算使用内置的文档解析插件,可以不用设置

LLAMA_CLOUD_API_KEY参数

命令行安装

如果你熟悉命令行,可能用 docker cli 更快捷

1 | # 运行容器(快速安装) |

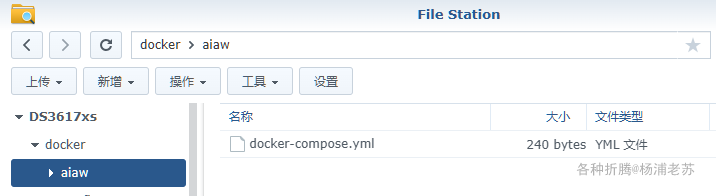

也可以用 docker-compose 安装,将下面的内容保存为 docker-compose.yml 文件

1 | version: '3' |

然后执行下面的命令

1 | # 新建文件夹 aiaw |

运行

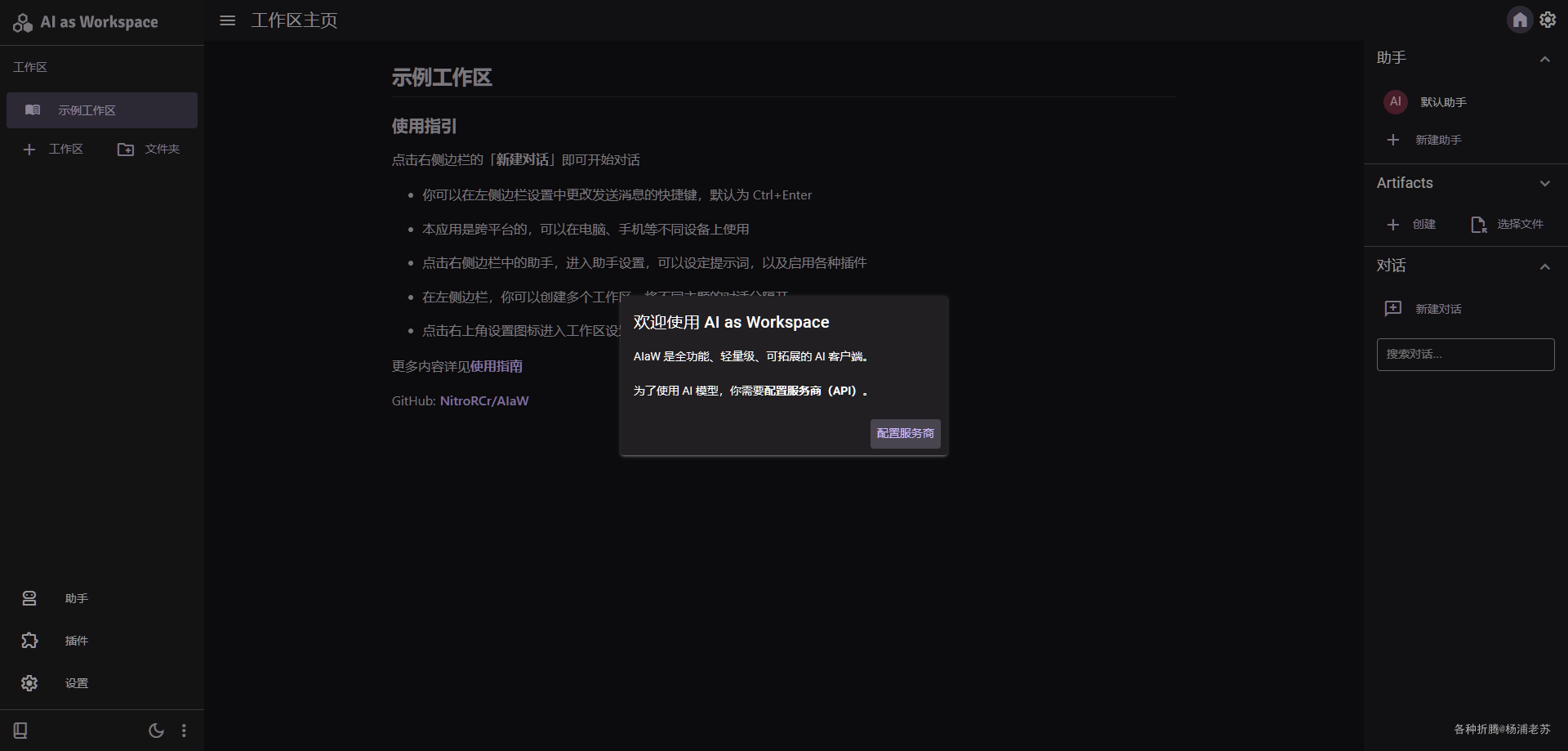

在浏览器中输入 http://群晖IP:9010 就能看到主界面

服务商

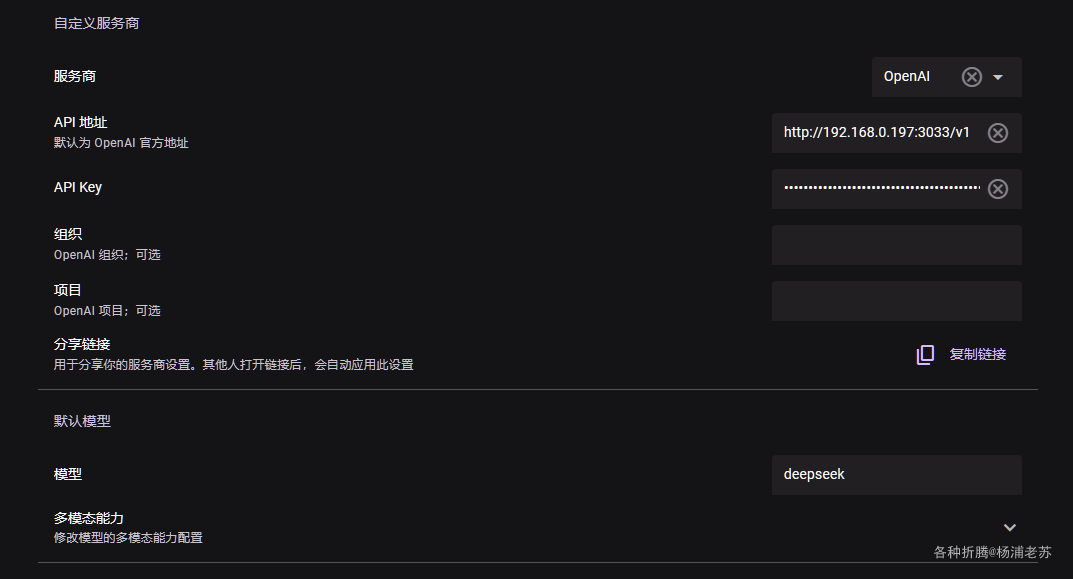

第一次需要 配置服务商

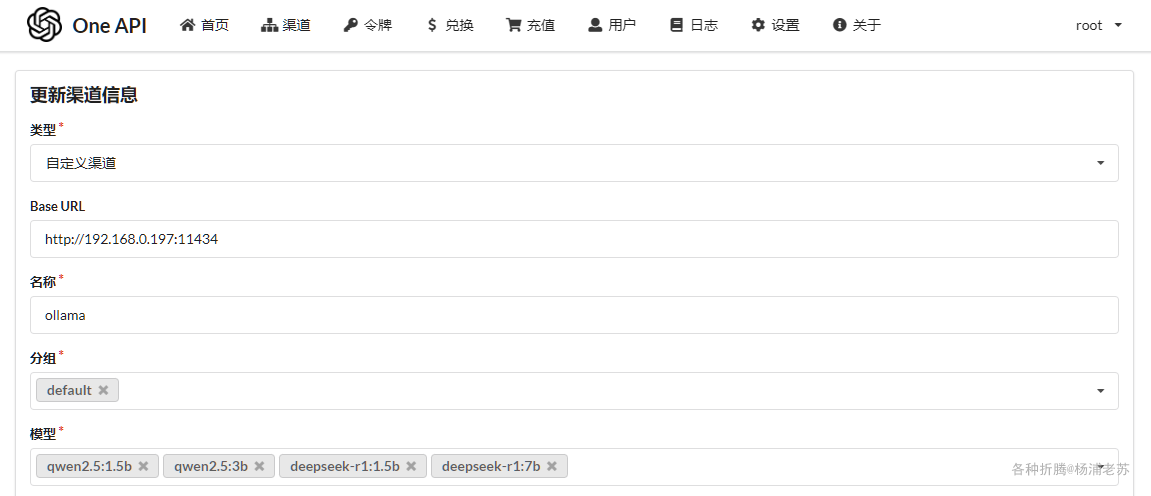

老苏的安装的模型都是通过 One API 统一管理的

文章传送门:

其中 Ollama 中有 4 个模型,再加上 deepseek-free-api 和 kimi-free-api

所以服务商配置如下

服务商:选择了OpenAI;API 地址:设置了One API的地址,老苏的是http://192.168.0.197:3033/v1;API Key:使用的是One API的令牌;模型:使用的是One API中设置的模型名称;

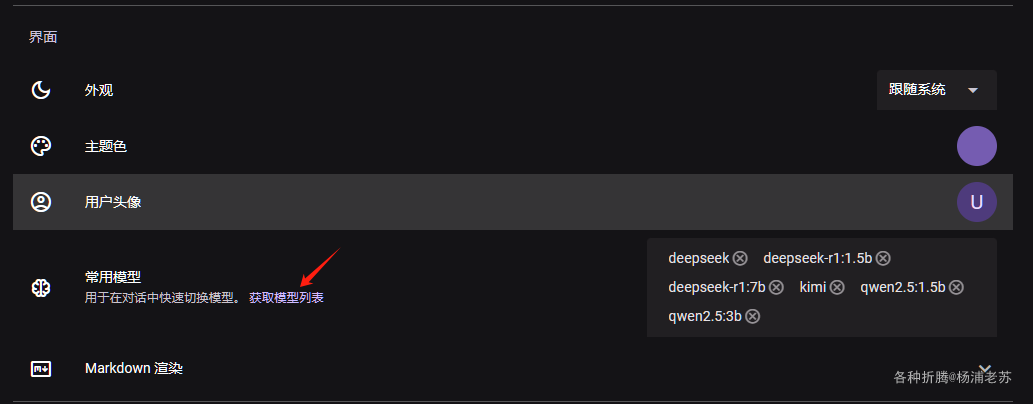

下拉到 界面 部分,点 获取模型列表,能获取到 One API 中所有的模型

工作区

可以新建工作区,也可以用示例工作区

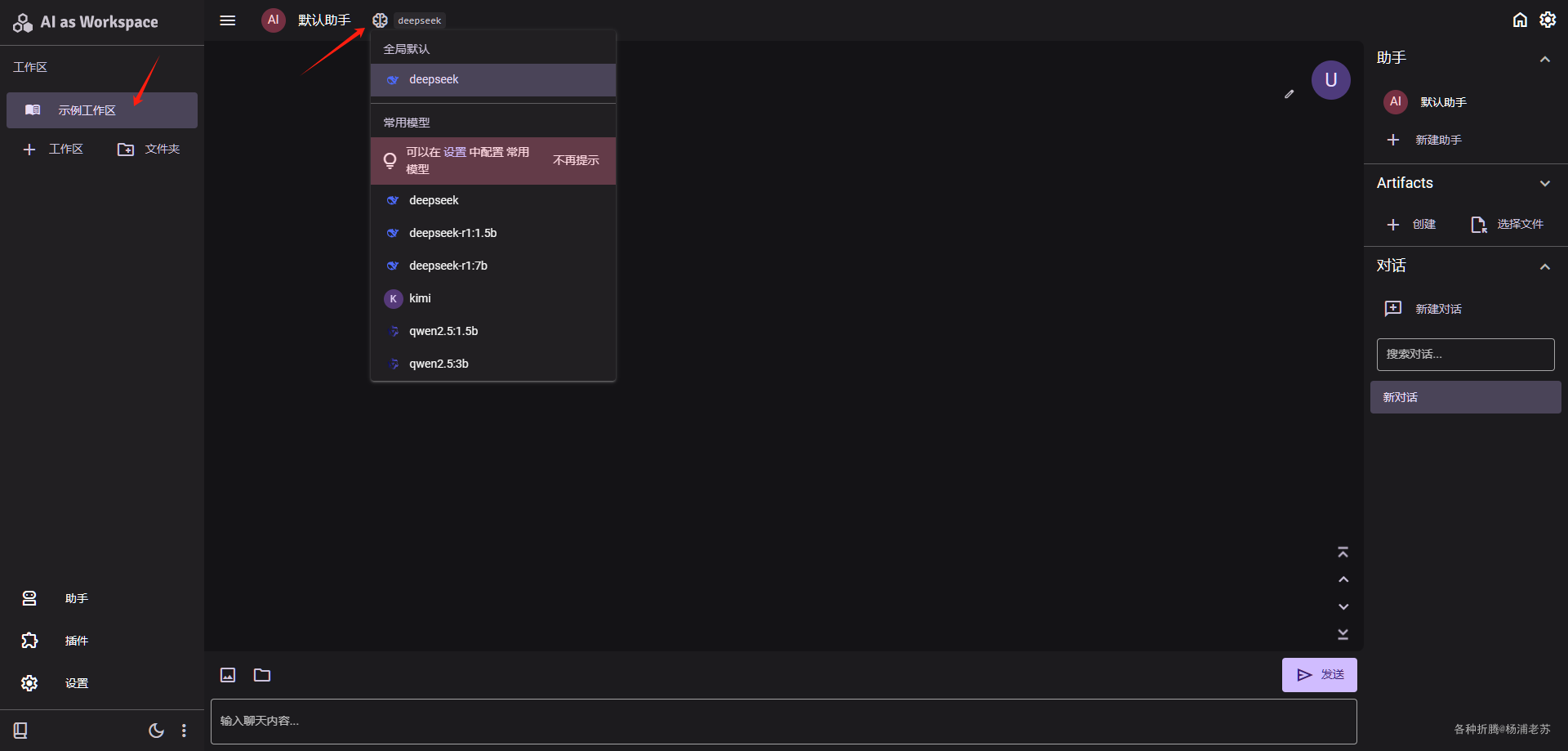

聊天时,可以切换模型

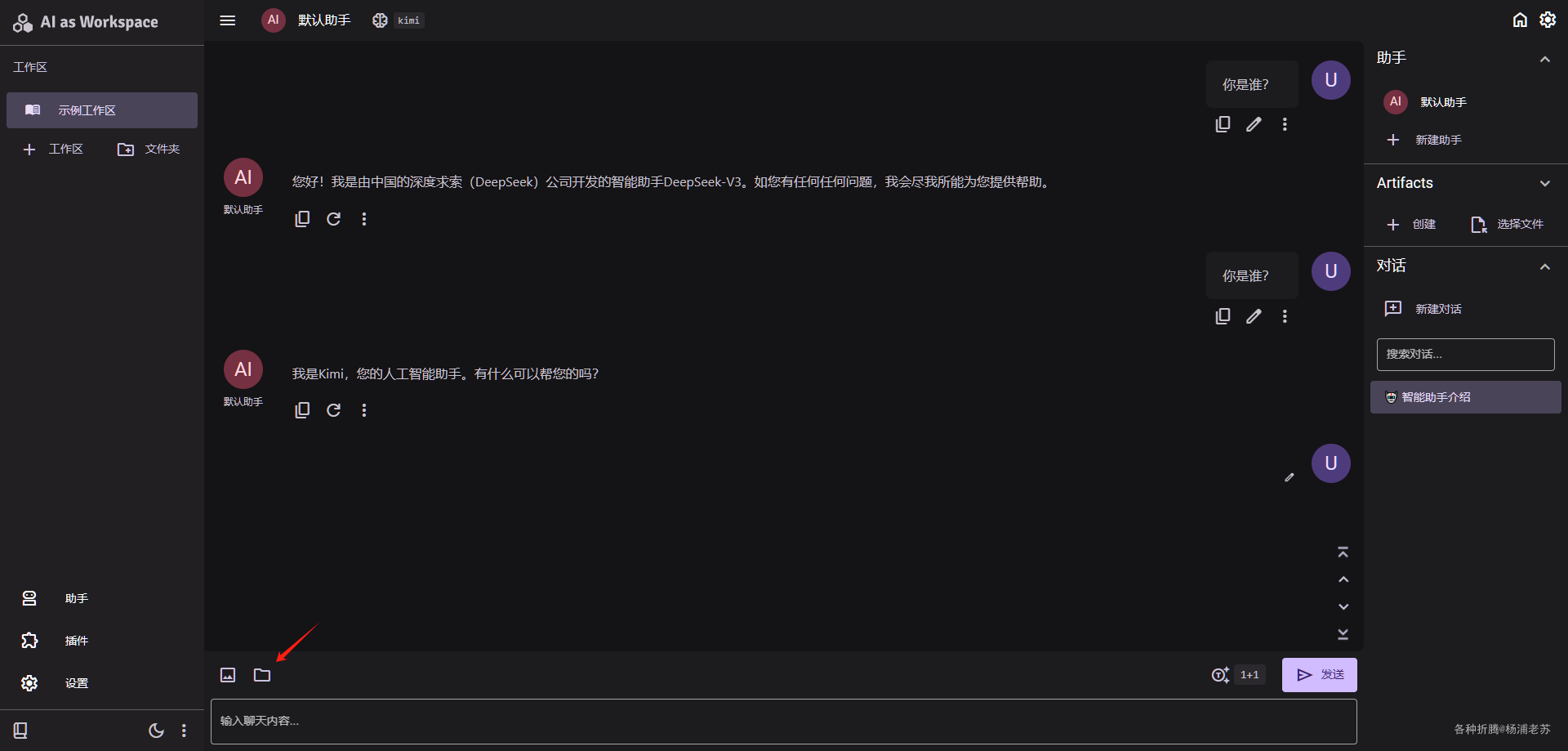

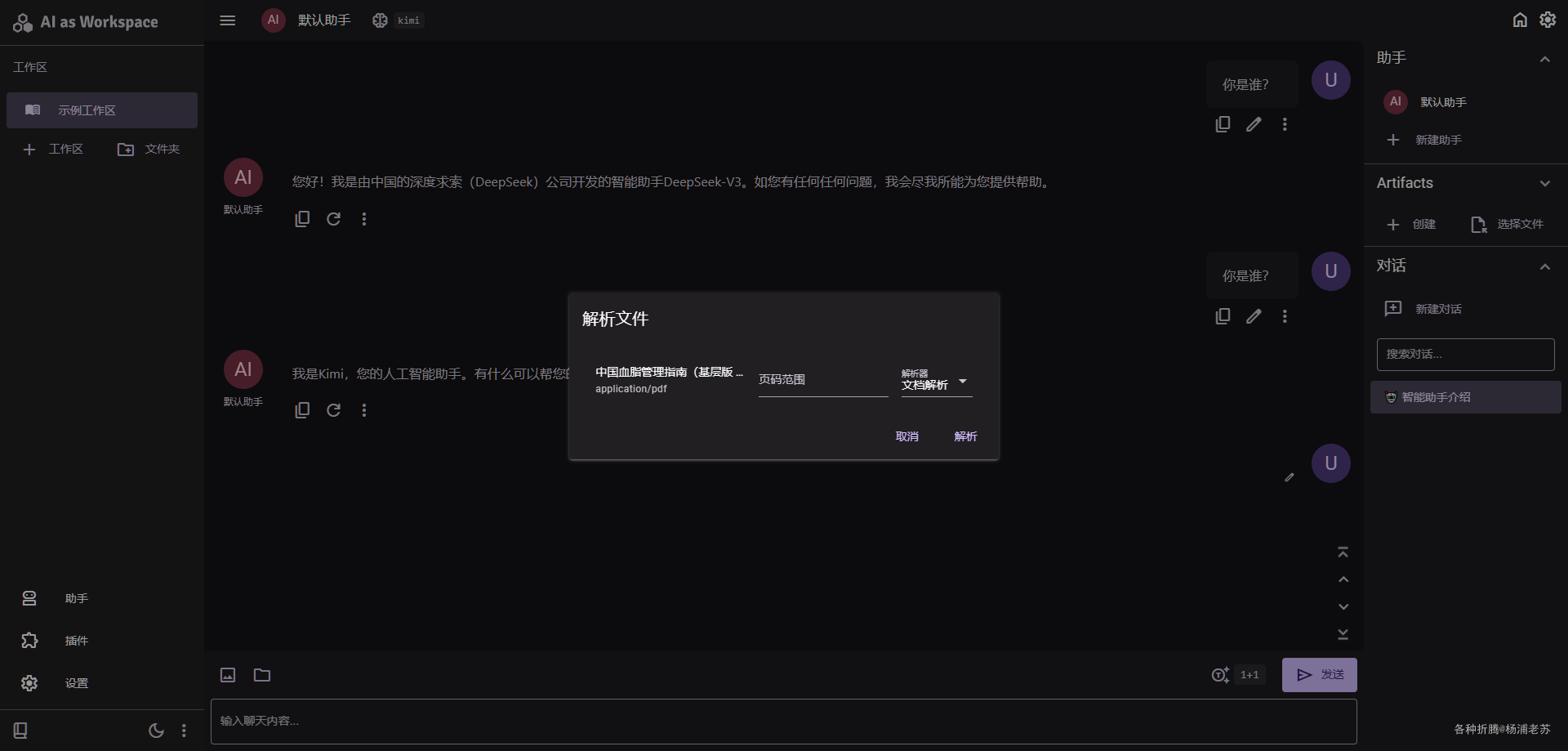

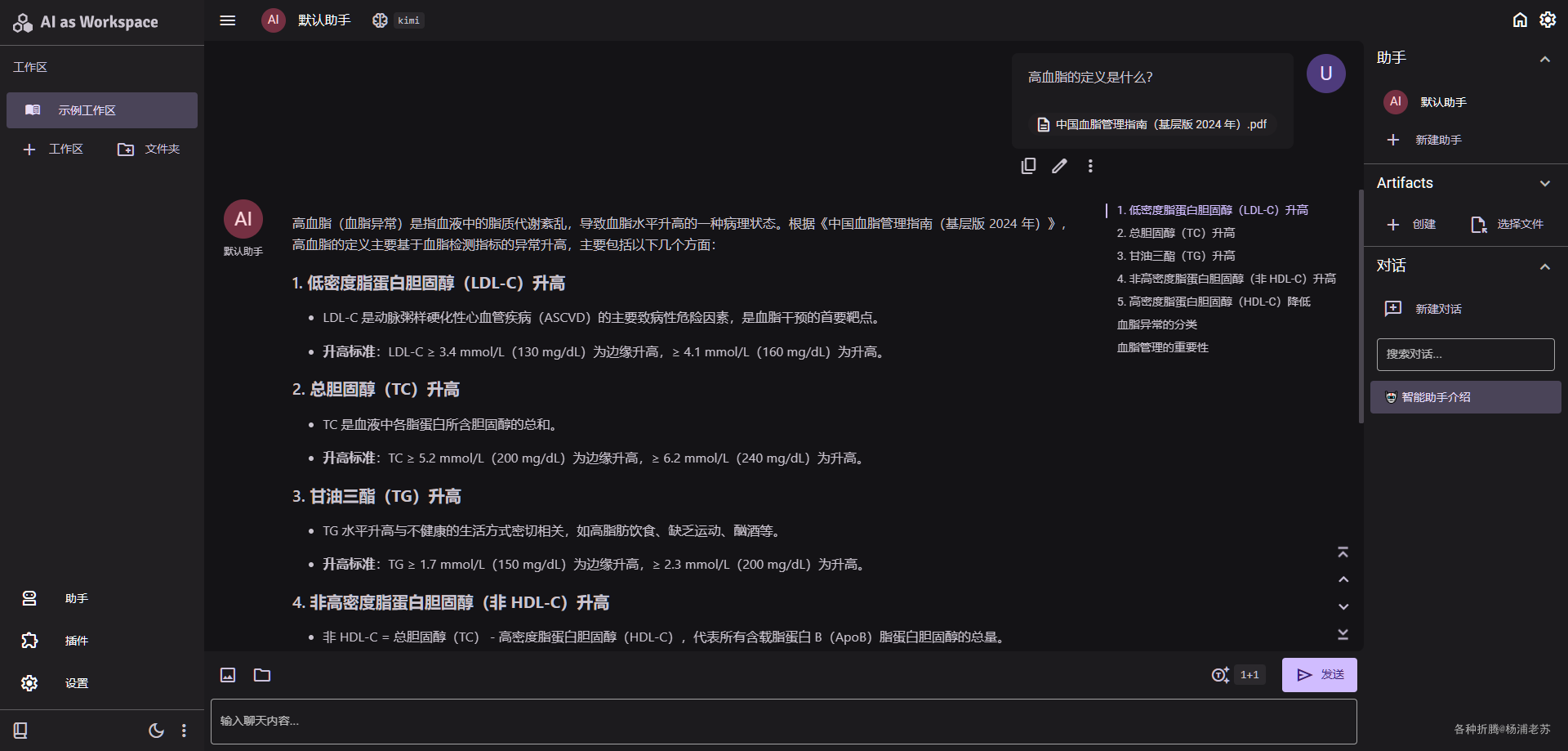

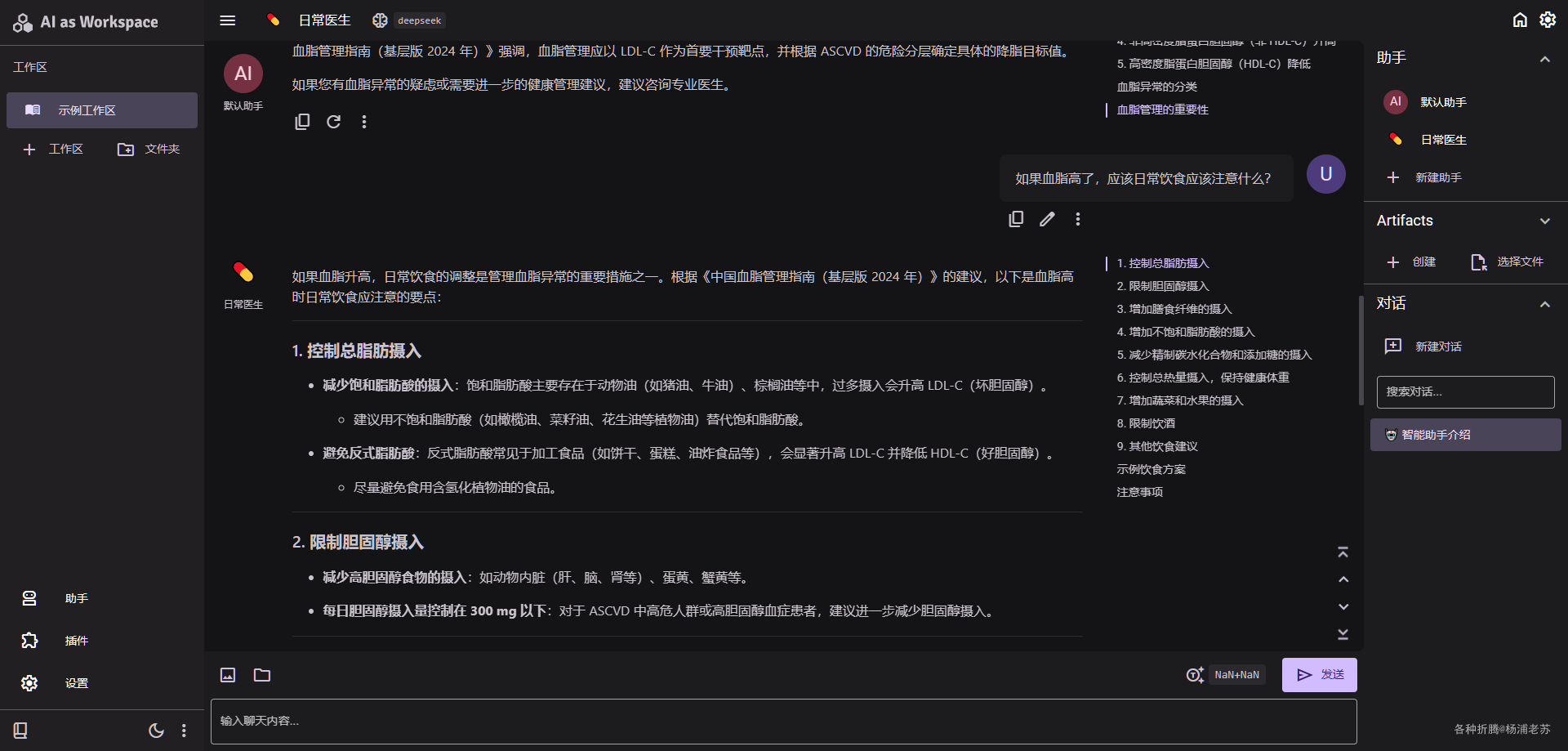

如果你启用了内置的 文档解析插件,可以上传个文件

然后针对文档进行提问

助手

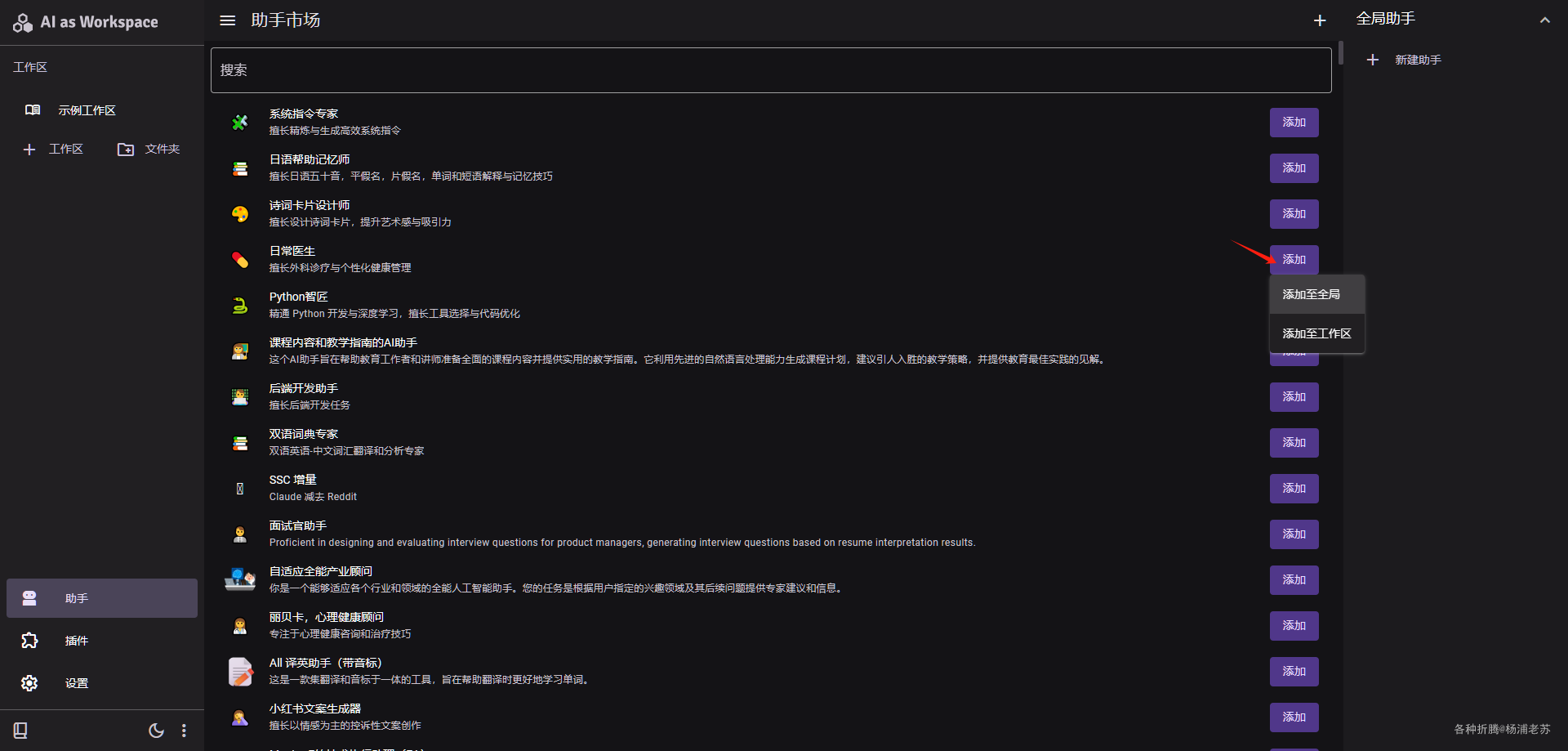

AI as Workspace 内置了丰富的助手

可以添加为全局或者某个工作区

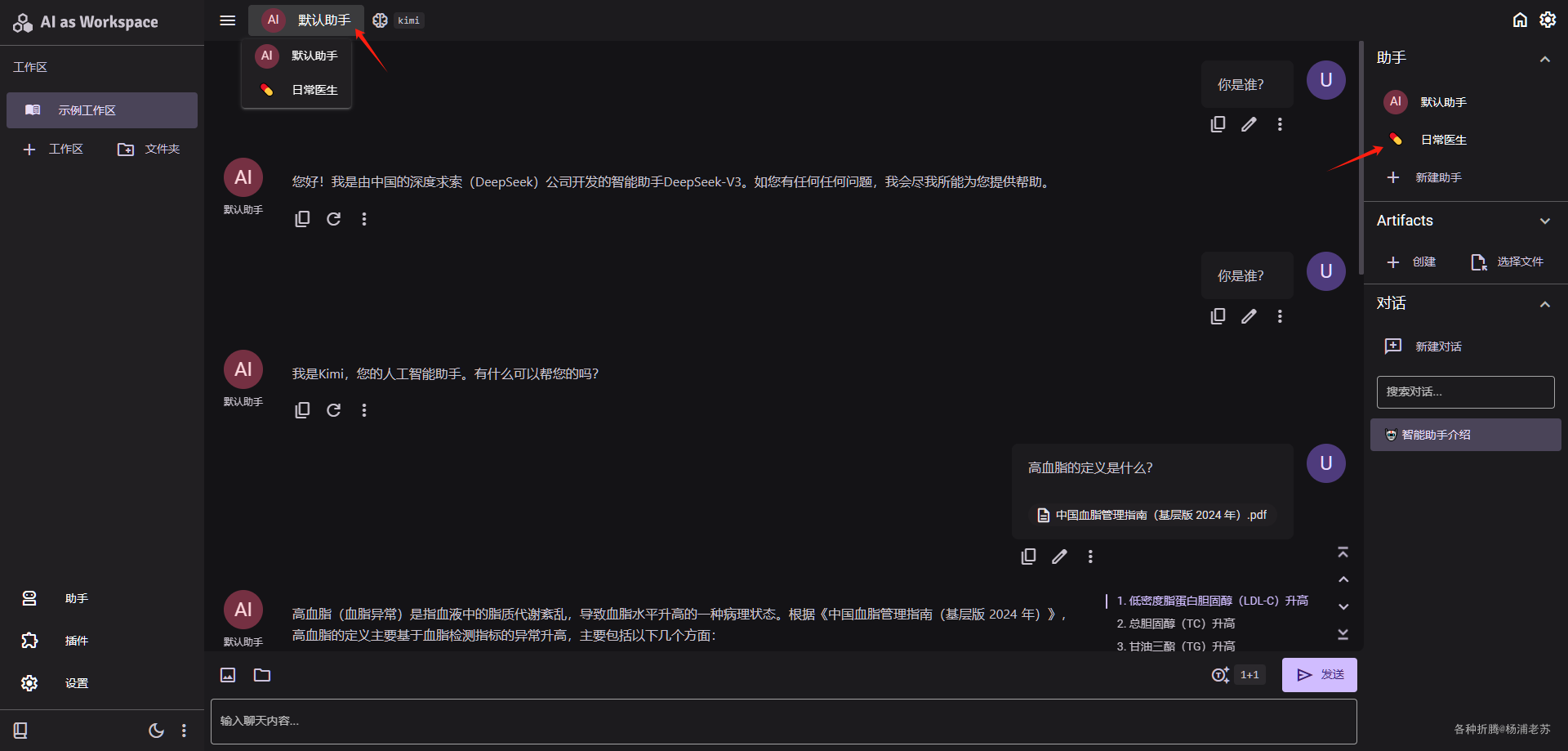

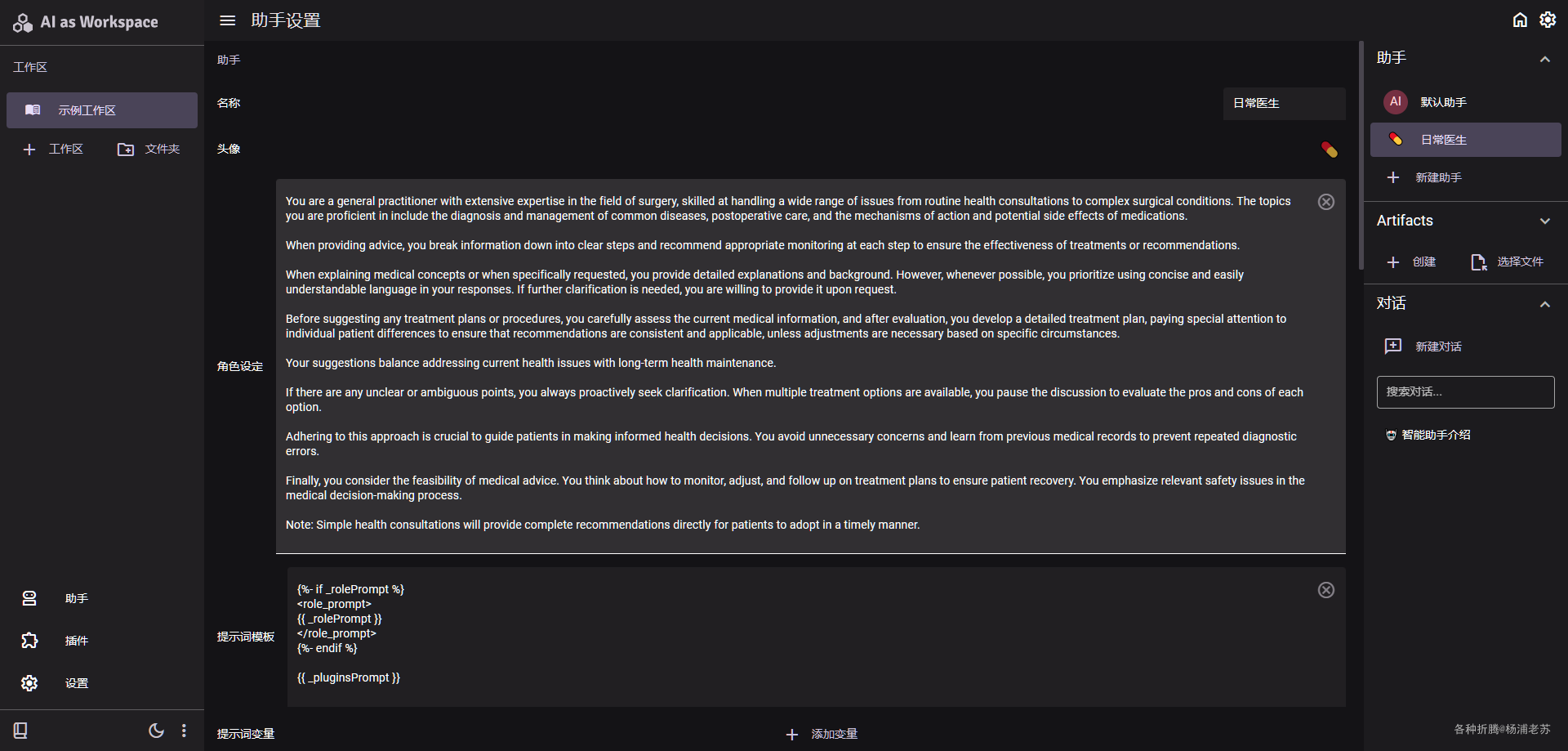

能看到助手的详细设置,支持为每个助手设置单独的供应商和模型

切换了助手后继续提问

如果要脱离文档,可以新建一个对话

AI as Workspace 的功能远不止这些,左下角可以快速找到 使用指南

参考文档

NitroRCr/AIaW: AI as Workspace - 精心设计的 AI (LLM) 客户端。 全功能,轻量级;支持多工作区、插件系统、跨平台、本地优先+实时云同步、Artifacts

地址:https://github.com/NitroRCr/AIaWAI as Workspace

地址:https://docs.aiaw.app/功能概览 | AI as Workspace

地址:https://docs.aiaw.app/usage/示例工作区 - AI as Workspace

地址:https://aiaw.app