群晖上私有化部署DeepSeek-R1

简介

上一篇介绍的 deepseek-free-api ,主要是提供接口服务,允许用户通过网络访问 DeepSeek 模型的能力。这意味着,尽管用户可以在本地容器中运行该 API,但实际的模型推理和处理仍依赖于远程服务器或云服务,用户在使用时需要考虑网络连接的稳定性和访问权限。

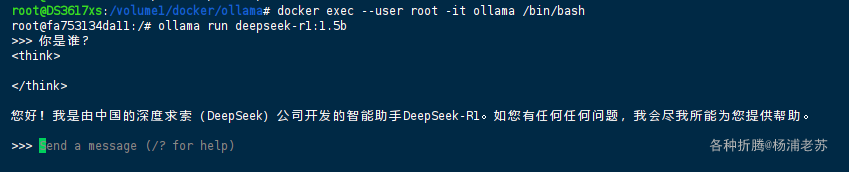

今天我们来研究通过 ollama 完全本地化部署 DeepSeek-R1

什么是 DeepSeek-R1 ?

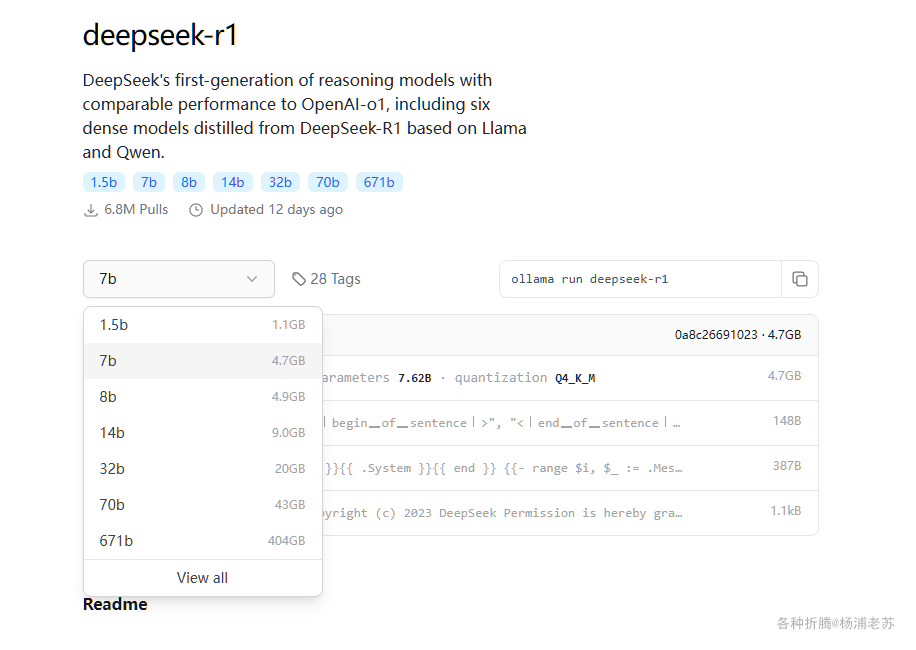

DeepSeek-R1是DeepSeek的第一代推理模型,在数学、代码和推理任务中,其性能与OpenAI-o1相当,包括基于Llama和Qwen的六个从DeepSeek-R1蒸馏出的密集模型。

什么是蒸馏 ?

蒸馏技术(

Distillation)是一种模型压缩和优化的方法,主要用于将一个大型、复杂的模型的知识转移到一个较小的模型中。这个过程通常被称为“知识蒸馏”(Knowledge Distillation)

其中 671b 是教师模型(Teacher Model), 另外的 6 个蒸馏模型为学生模型(Student Model)

1.5b:全称是DeepSeek-R1-Distill-Qwen-1.5B,蒸馏模型源自Qwen-2.5系列;7b:是DeepSeek-R1-Distill-Qwen-7B,蒸馏模型源自Qwen-2.5系列;8b:是DeepSeek-R1-Distill-Llama-8B,蒸馏模型源自Llama3.1-8B-Base;14b:是DeepSeek-R1-Distill-Qwen-14B,蒸馏模型源自Qwen-2.5系列;32b:是DeepSeek-R1-Distill-Qwen-32B,蒸馏模型源自Qwen-2.5系列;70b:是DeepSeek-R1-Distill-Llama-70B,蒸馏模型源自Llama3.3-70B-Instruct;

安装

ollama

- 首先要安装本地大模型运行框架

ollama; - 再根据机器的性能,下载对应参数的

DeepSeek-R1模型;

| 模型版本 | 适用场景 | 内存占用 | 推理速度 |

|---|---|---|---|

| 1.5b | 轻量级任务 | 3GB | 15 token/s |

| 7b | 常规对话 | 10GB | 8 token/s |

| 70b | 复杂推理 | 48GB | 2 token/s |

需要说明的是,ollama 除了 docker 方式部署外,也支持主流操作系统(Windows、macOS 或 Linux)的二进制安装包

当然老苏还是更喜欢在 NAS 上用 docker 方式部署

文章传送门:本地大模型运行框架Ollama

1 | # 新建文件夹 ollama 和 子目录 |

WebUI

命令行方式用起来毕竟还是不太方便,虽然支持 ollama 的 WebUI 很多,而且也可以接入 One API 进行统一管理 ,但老苏觉得最佳的交互体验组合应该还是 Open WebUI

文章传送门:适配Ollama的前端界面Open WebUI

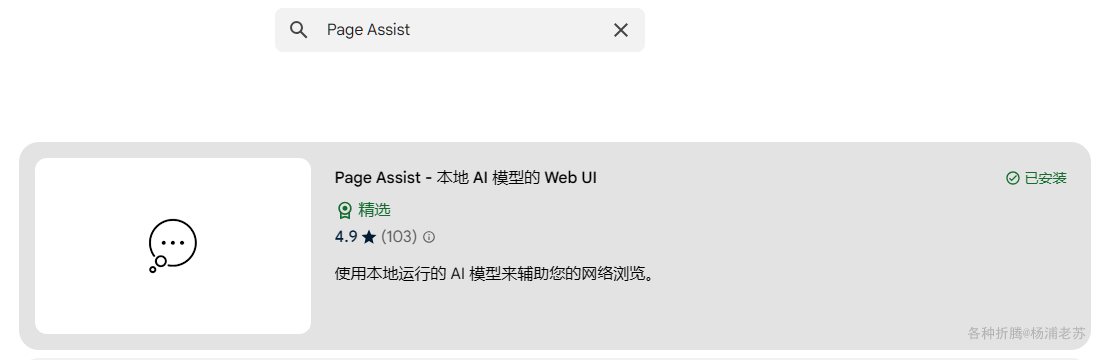

不过今天老苏不打算使用 Open WebUI,而是给大家推荐一款浏览器插件 Page Assist。

它通过插件形式直接集成到侧边栏,无需复杂配置即可一键调用本地部署的 AI 模型,让您可以从任何网页与您的模型进行交互。

相比传统 WebUI,Page Assist 具备一定的技术优势

| 特性 | 传统 WebUI | Page Assist |

|---|---|---|

| 部署复杂度 | 需独立服务部署 | 浏览器插件即装即用 |

| 资源占用 | 200MB+ 内存 | <50MB 内存 |

| 上下文感知能力 | 手动复制粘贴 | 自动捕获网页选区 |

| 多模型切换 | 需重新加载页面 | 实时无缝切换 |

目前支持的浏览器

| 浏览器 | 侧边栏 | 与网页聊天 | 网页界面 |

|---|---|---|---|

| Chrome | ✅ | ✅ | ✅ |

| Brave | ✅ | ✅ | ✅ |

| Firefox | ✅ | ✅ | ✅ |

| Vivaldi | ✅ | ✅ | ✅ |

| Edge | ✅ | ❌ | ✅ |

| LibreWolf | ✅ | ✅ | ✅ |

| Zen Browser | ✅ | ✅ | ✅ |

| Opera | ❌ | ❌ | ✅ |

| Arc | ❌ | ❌ | ✅ |

运行

设置

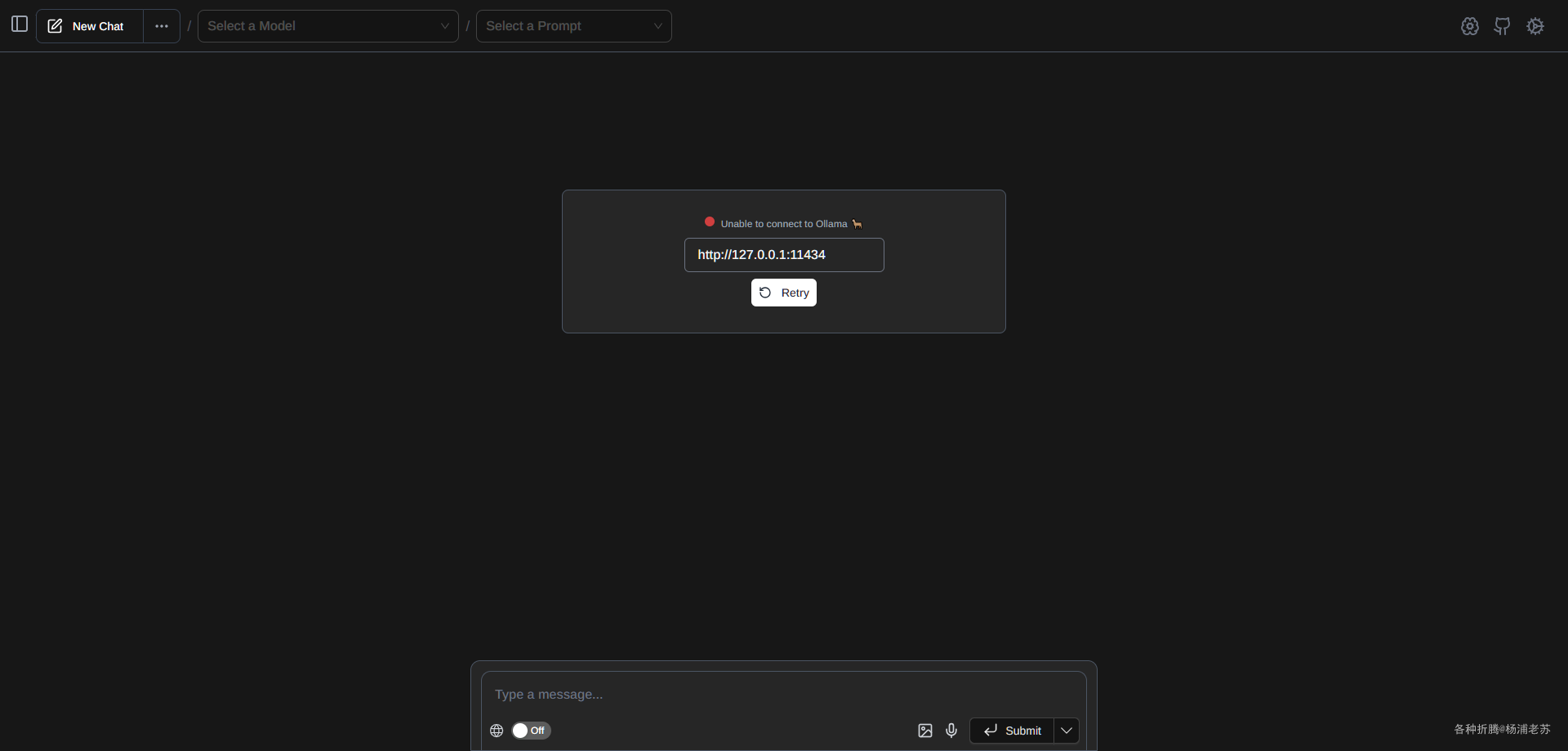

在浏览器中打开插件,会看到错误信息 Unable to connect to Ollama

这是因为我们并没有在本机安装

ollama,而是安装在NAS上,因此不能通过127.0.0.1或者localhost进行访问。

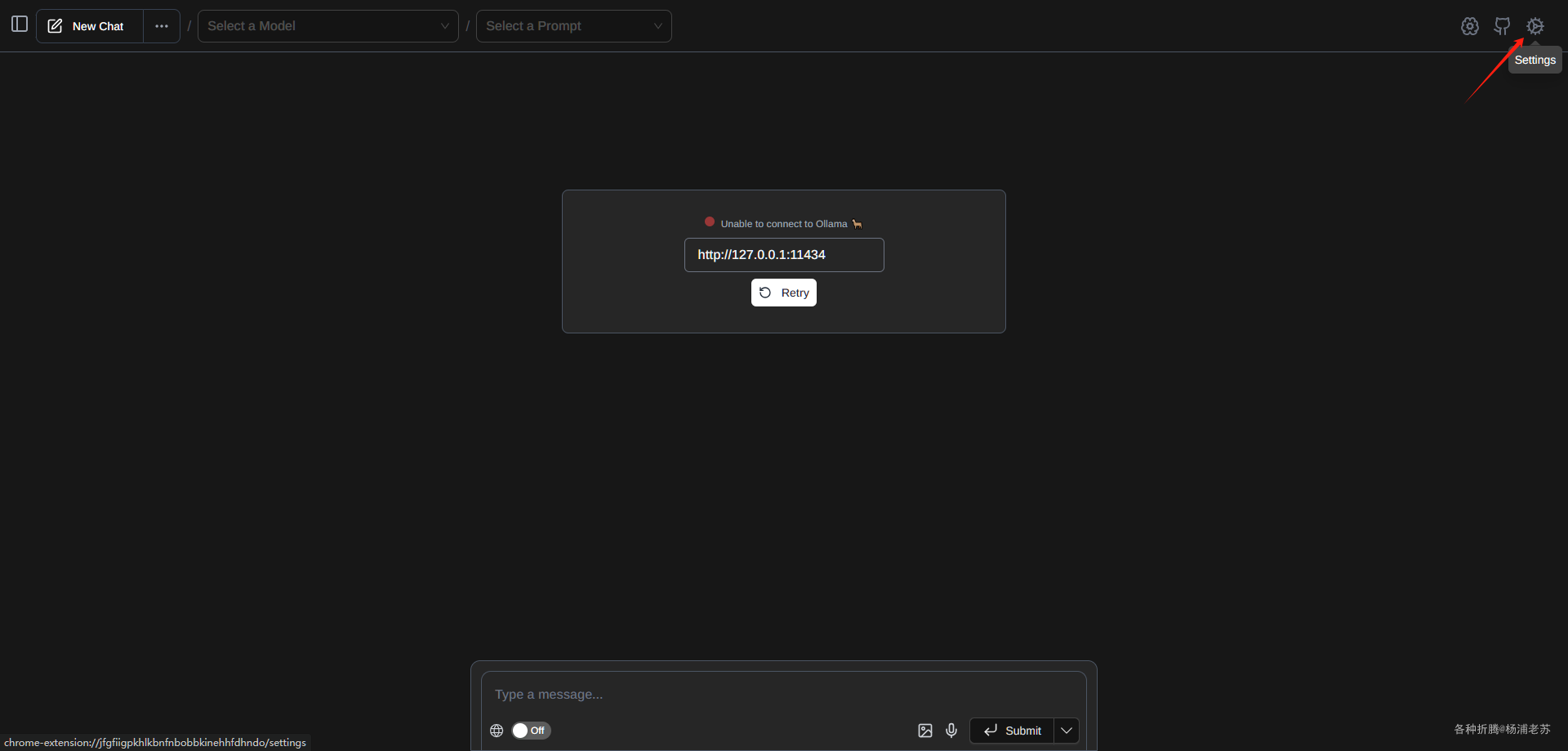

- 单击右上角的

Settings图标

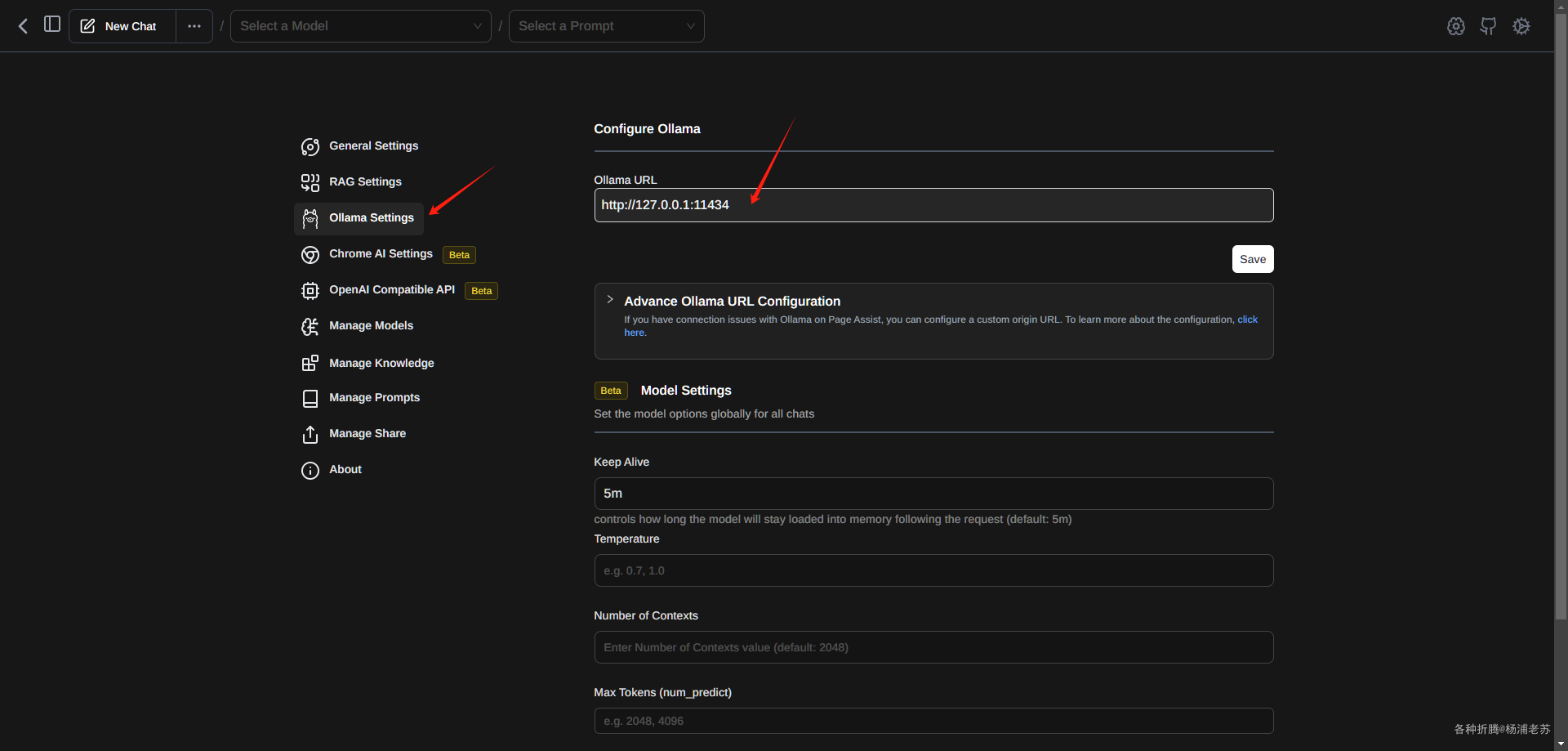

- 单击选项卡

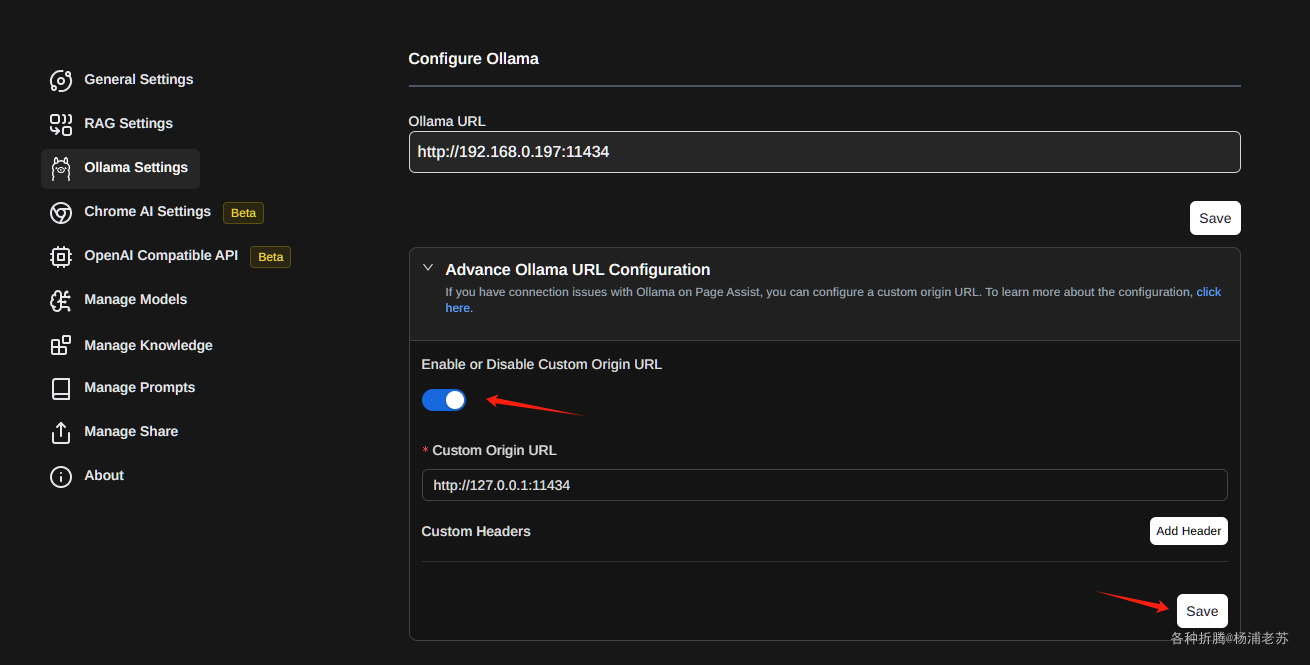

Ollama Settings

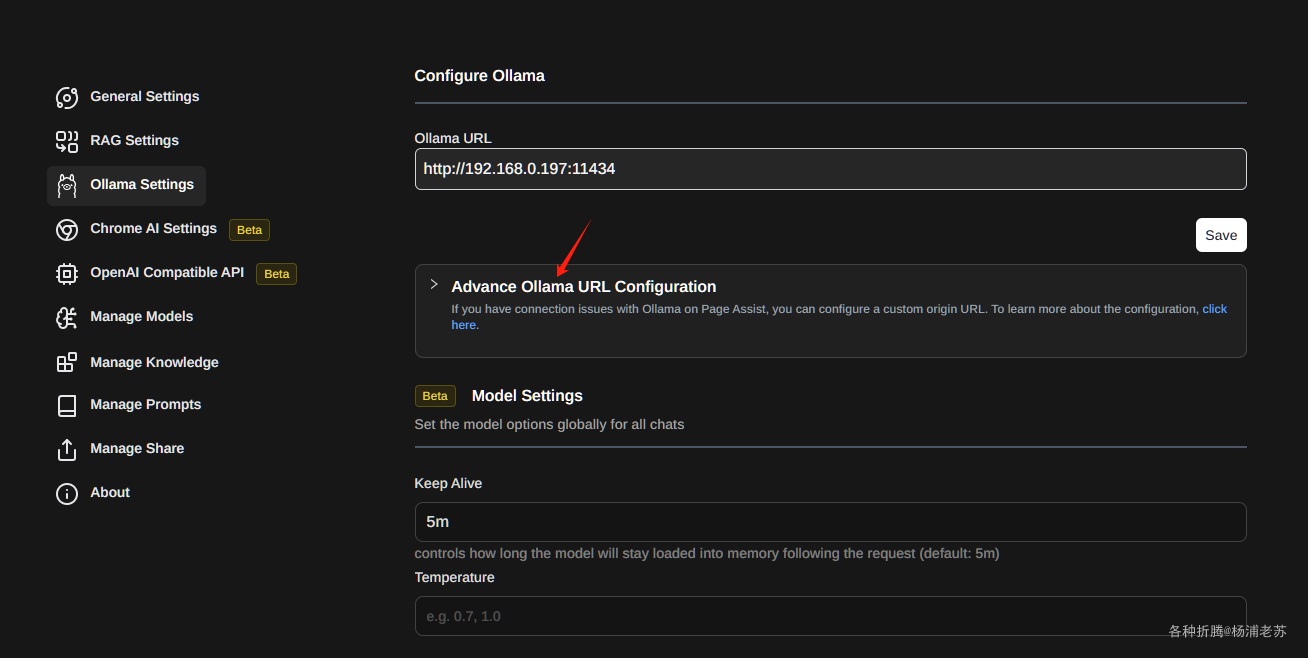

- 修改

Ollama URL并点save保存

- 展开

Advance Ollama URL Configuration选项,并启用Enable or Disable Custom Origin URL

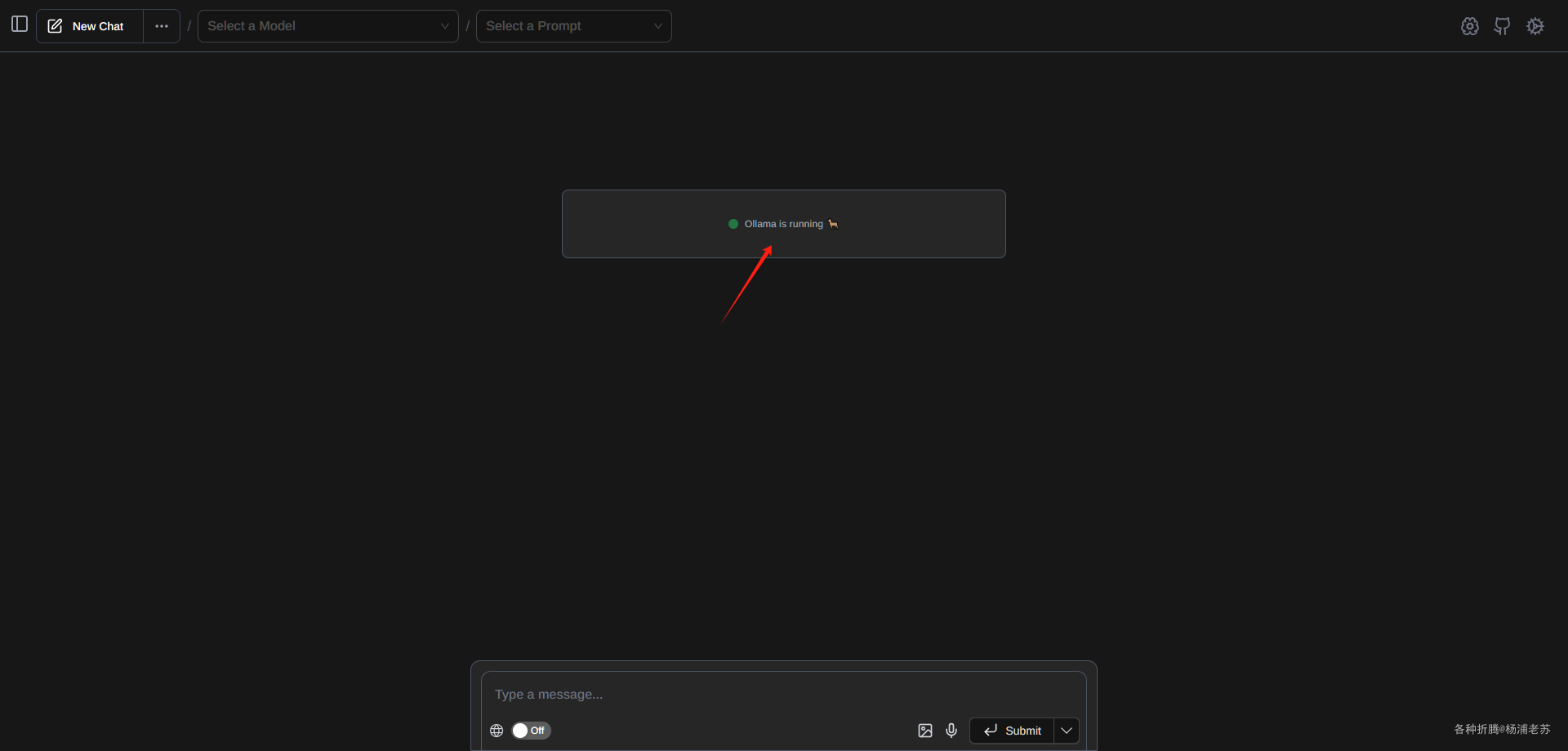

- 回到主界面,如果

Ollama URL地址没问题,应该会看到Ollama is running 🦙

中文

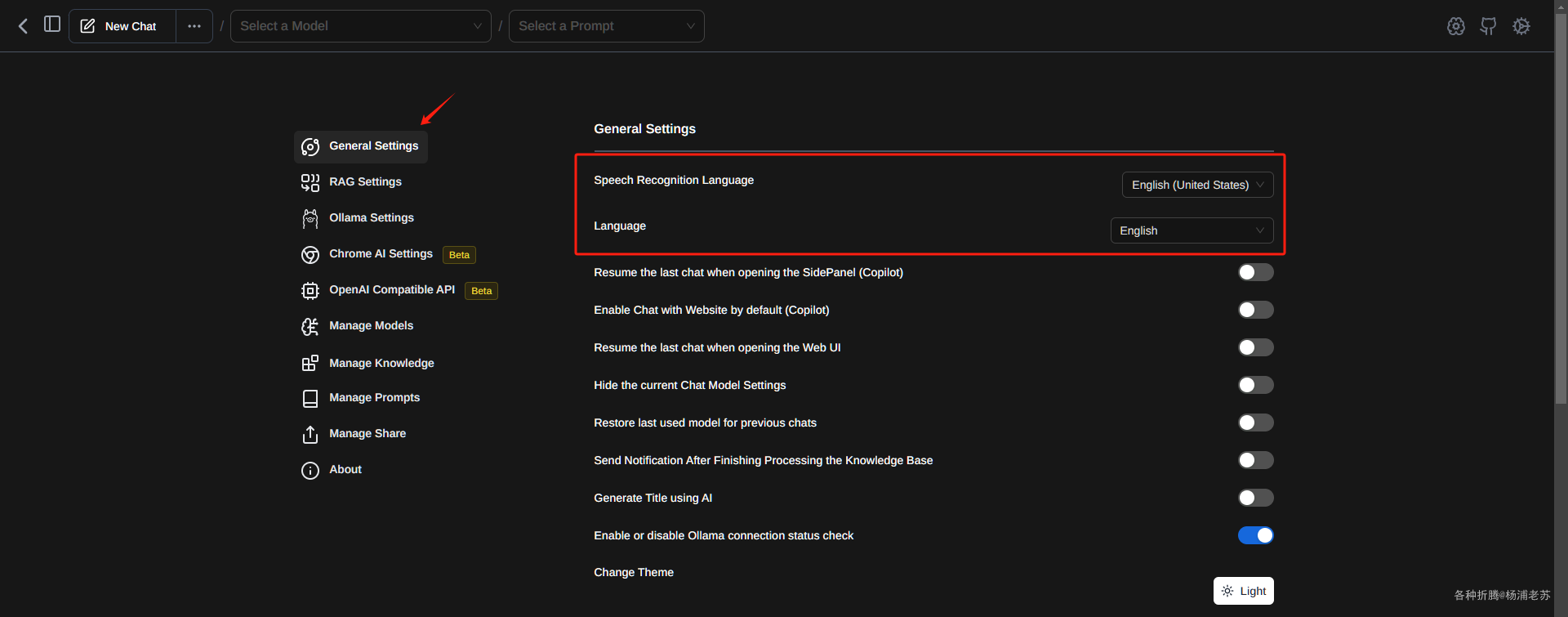

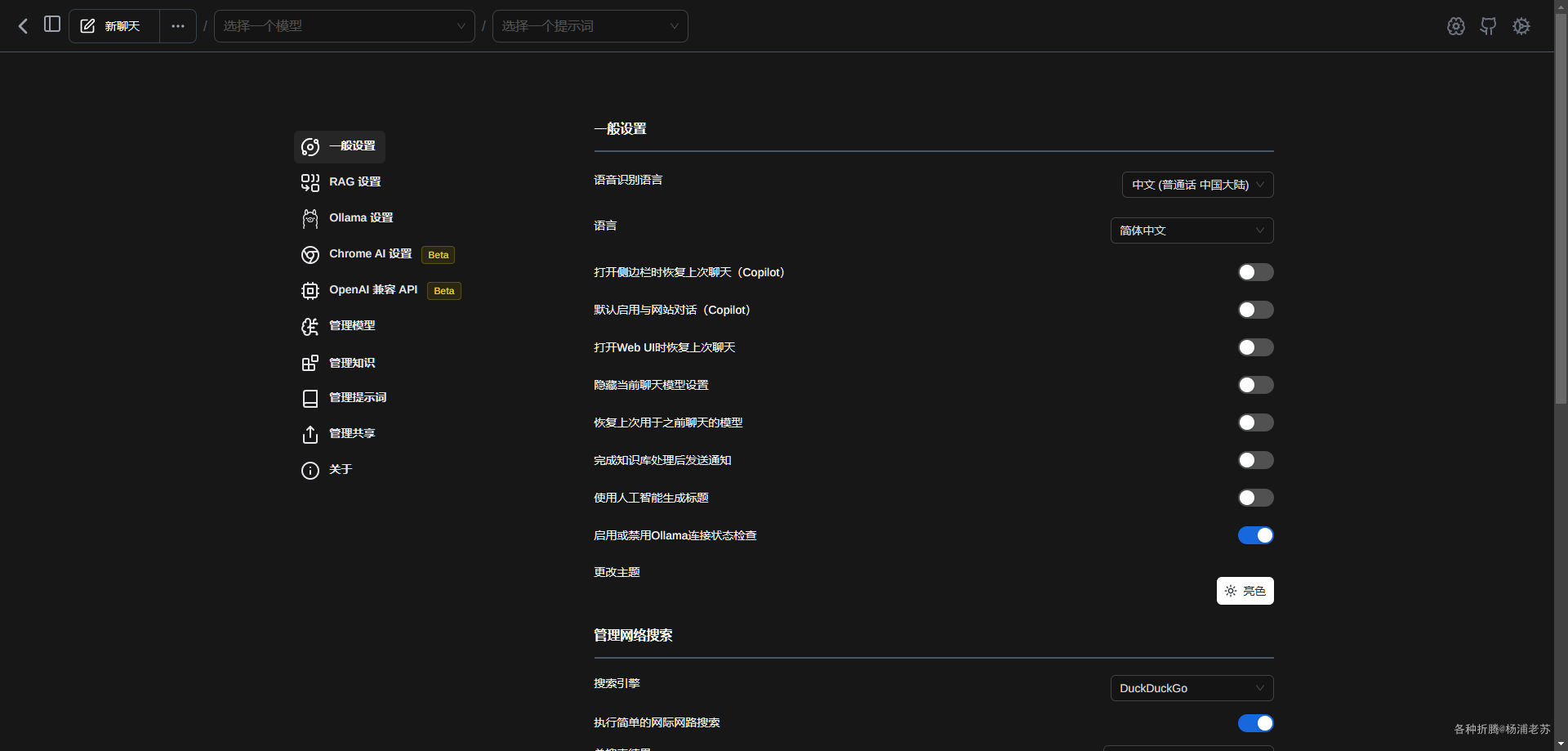

这一步不是必须的,只是大部分人,也包括老苏,更习惯中文的使用环境

在设置界面 –> General Settings

设置为 简体中文

聊天

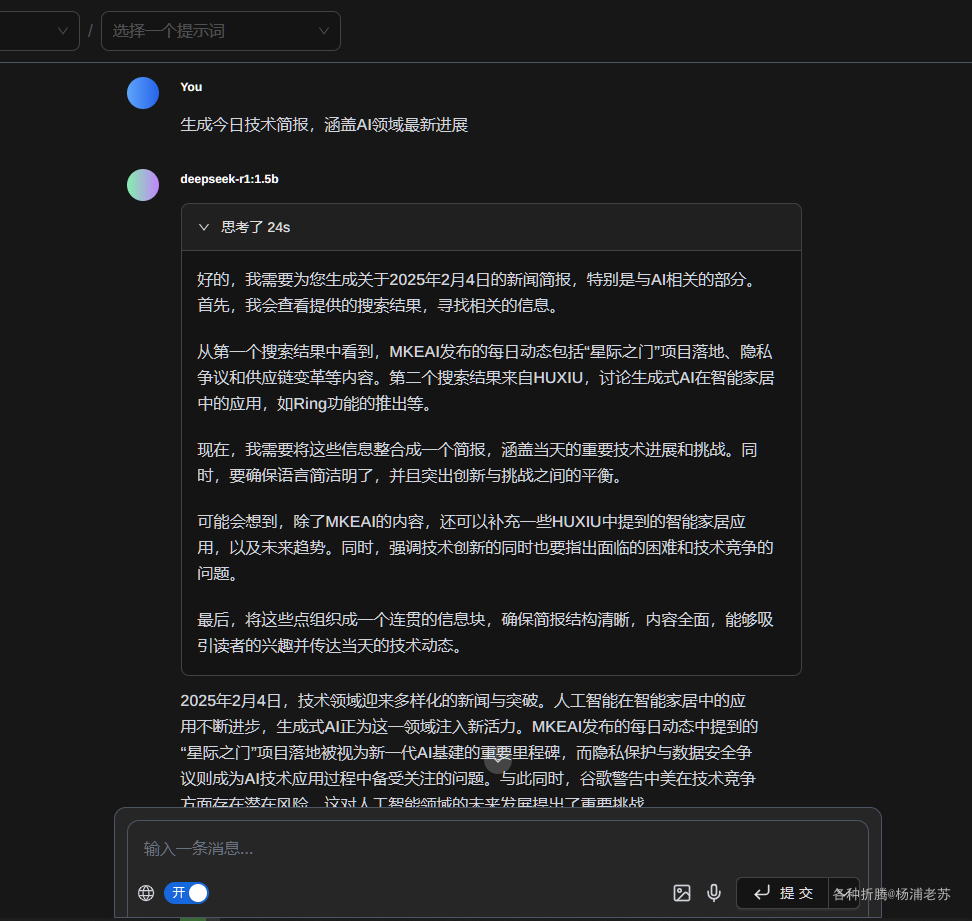

现在可以开始聊天了。因为机器性能的缘故,老苏用的是 1.5b 的模型

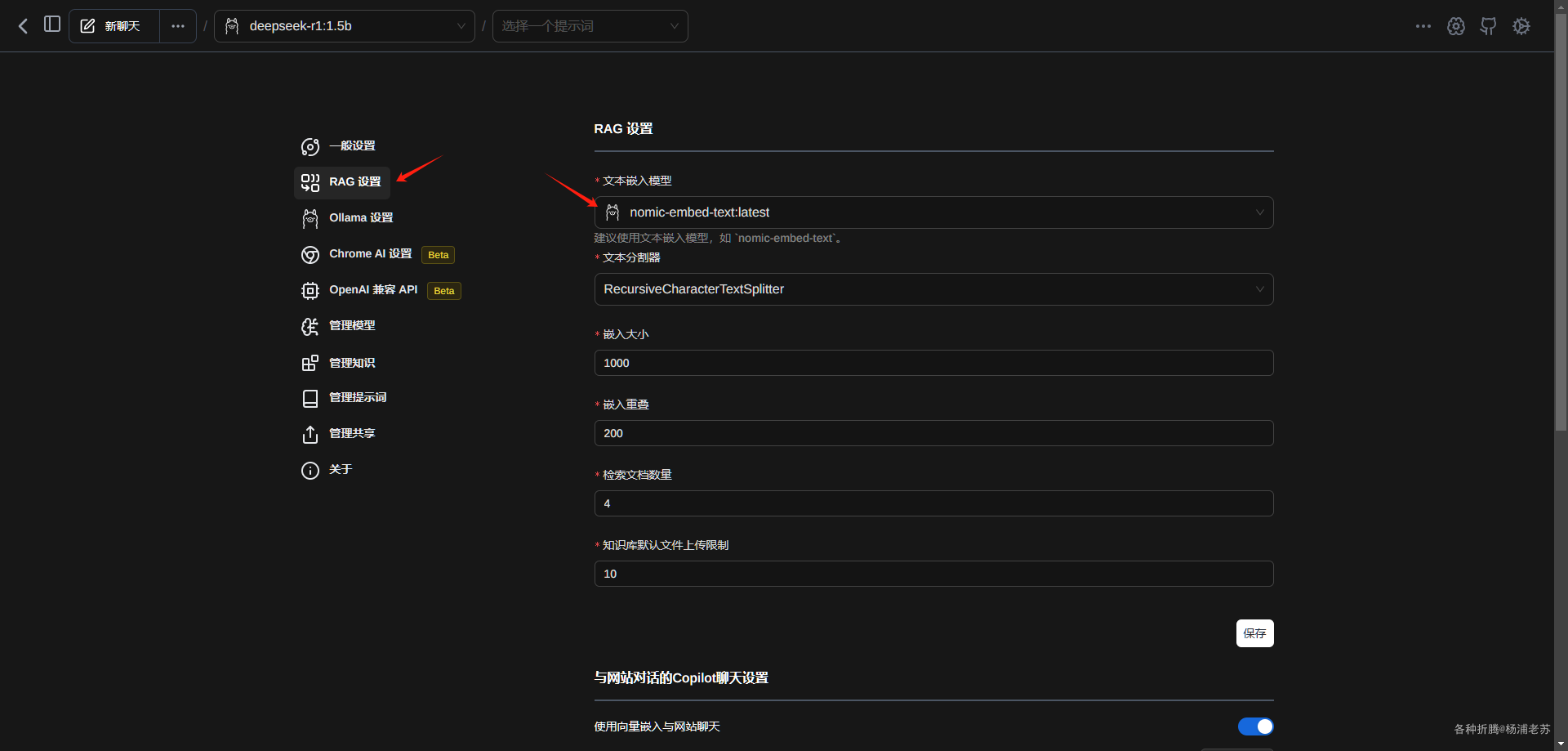

联网会需要用到文本嵌入模型

老苏使用了推荐的 nomic-embed-text

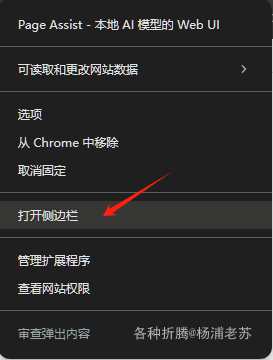

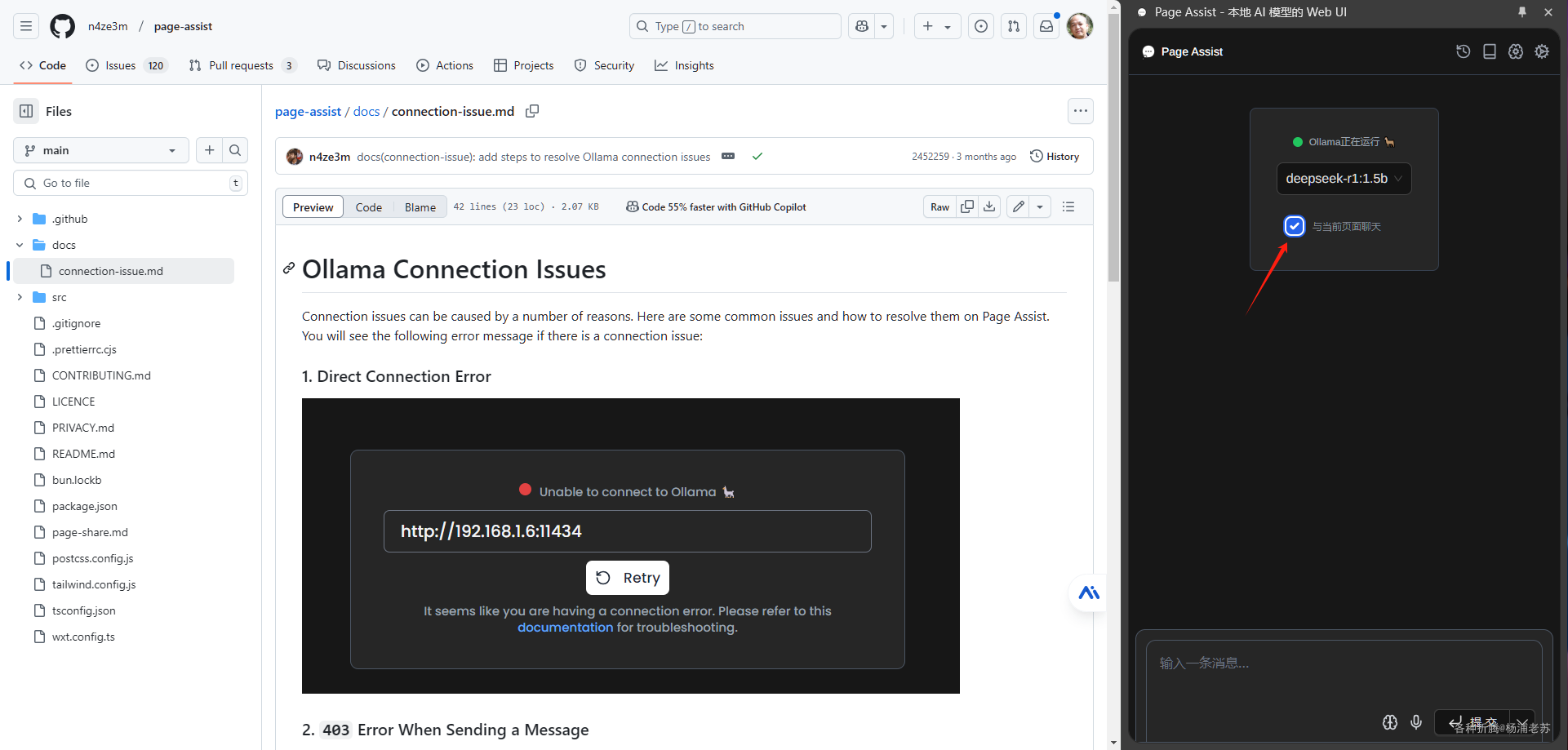

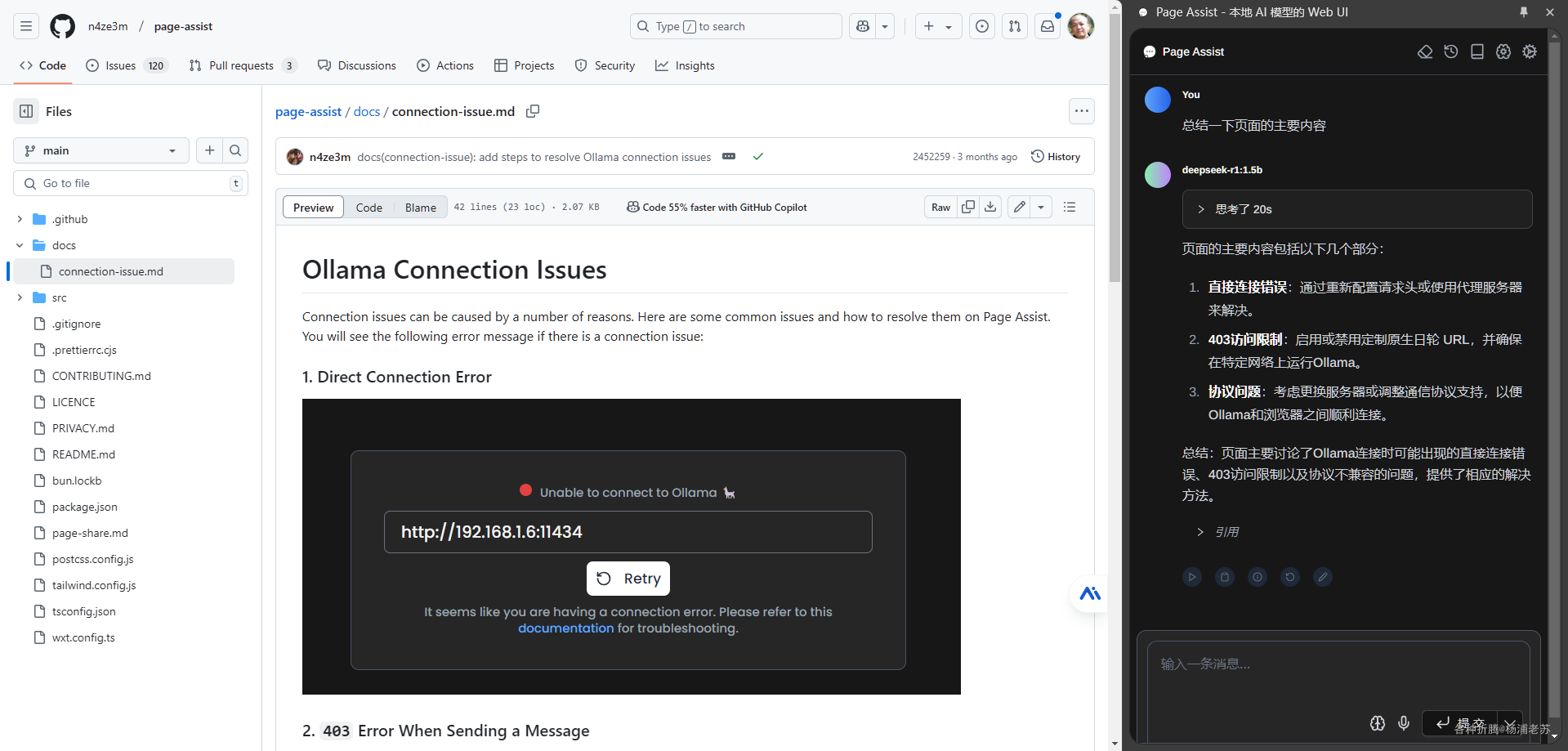

侧边栏

在任意一个网页,选中 Page Assist 插件点右键菜单,启动 侧边栏

勾选 与当前页面聊天

让模型总结一下页面的内容

参考文档

DeepSeek - 探索未至之境

地址:https://chat.deepseek.com/deepseek-r1

地址:https://ollama.com/library/deepseek-r1n4ze3m/page-assist: Use your locally running AI models to assist you in your web browsing

地址:https://github.com/n4ze3m/page-assistpage-assist/docs/connection-issue.md at main · n4ze3m/page-assist

地址:https://github.com/n4ze3m/page-assist/blob/main/docs/connection-issue.md